Proceso gaussiano - Gaussian process

En teoría de probabilidad y estadística , un proceso gaussiano es un proceso estocástico (una colección de variables aleatorias indexadas por tiempo o espacio), de modo que cada colección finita de esas variables aleatorias tiene una distribución normal multivariante , es decir, cada combinación lineal finita de ellas es normalmente repartido. La distribución de un proceso gaussiano es la distribución conjunta de todas esas (infinitas) variables aleatorias y, como tal, es una distribución sobre funciones con un dominio continuo, por ejemplo, tiempo o espacio.

El concepto de procesos gaussianos lleva el nombre de Carl Friedrich Gauss porque se basa en la noción de distribución gaussiana ( distribución normal ). Los procesos gaussianos pueden verse como una generalización de dimensiones infinitas de distribuciones normales multivariadas.

Los procesos gaussianos son útiles en el modelado estadístico , beneficiándose de las propiedades heredadas de la distribución normal. Por ejemplo, si un proceso aleatorio se modela como un proceso gaussiano, las distribuciones de varias cantidades derivadas se pueden obtener explícitamente. Tales cantidades incluyen el valor promedio del proceso en un rango de tiempos y el error al estimar el promedio usando valores de muestra en un pequeño conjunto de tiempos. Si bien los modelos exactos a menudo escalan mal a medida que aumenta la cantidad de datos, se han desarrollado múltiples métodos de aproximación que a menudo conservan una buena precisión al tiempo que reducen drásticamente el tiempo de cálculo.

Definición

Un proceso estocástico continuo en el tiempo es gaussiano si y solo si para cada conjunto finito de índices en el conjunto de índices

es una variable aleatoria gaussiana multivariante . Eso es lo mismo que decir que cada combinación lineal de tiene una distribución normal univariante (o gaussiana).

Utilizando funciones características de variables aleatorias, la propiedad gaussiana se puede formular de la siguiente manera: es gaussiana si y solo si, para cada conjunto finito de índices , hay valores reales , de modo que la siguiente igualdad se cumple para todos

- .

donde denota la unidad imaginaria tal que .

Se puede demostrar que los números y son las covarianzas y medias de las variables en el proceso.

Diferencia

La varianza de un proceso gaussiano es finita en cualquier momento , formalmente

- .

Estacionariedad

Para los procesos estocásticos generales, la estacionariedad en sentido estricto implica una estacionariedad en sentido amplio, pero no todos los procesos estocásticos estacionarios en sentido amplio son estacionarios en sentido estricto. Sin embargo, para un proceso estocástico gaussiano, los dos conceptos son equivalentes.

Un proceso estocástico gaussiano es estacionario en sentido estricto si, y solo si, es estacionario en sentido amplio.

Ejemplo

Hay una representación explícita de los procesos gaussianos estacionarios. Un ejemplo simple de esta representación es

donde y son variables aleatorias independientes con la distribución normal estándar .

Funciones de covarianza

Un hecho clave de los procesos gaussianos es que pueden definirse completamente mediante sus estadísticas de segundo orden. Por lo tanto, si se supone que un proceso gaussiano tiene una media de cero, definir la función de covarianza define completamente el comportamiento del proceso. Es importante destacar que la definición no negativa de esta función permite su descomposición espectral utilizando la expansión Karhunen-Loève . Los aspectos básicos que se pueden definir a través de la función de covarianza son la estacionariedad , isotropía , suavidad y periodicidad del proceso .

La estacionariedad se refiere al comportamiento del proceso con respecto a la separación de dos puntos cualesquiera y . Si el proceso es estacionario, depende de su separación, mientras que si no es estacionario, depende de la posición real de los puntos y . Por ejemplo, el caso especial de un proceso de Ornstein-Uhlenbeck , un proceso de movimiento browniano , es estacionario.

Si el proceso depende solo de la distancia euclidiana (no la dirección) entre y , entonces el proceso se considera isotrópico. Un proceso que es simultáneamente estacionario e isotrópico se considera homogéneo ; en la práctica, estas propiedades reflejan las diferencias (o más bien la falta de ellas) en el comportamiento del proceso dada la ubicación del observador.

En última instancia, los procesos gaussianos se traducen en la adopción de priores en funciones y la suavidad de estos priores puede ser inducida por la función de covarianza. Si esperamos que para "cerca-por" puntos de entrada y sus puntos de salida correspondientes y para ser "cerca-by" también, entonces la suposición de continuidad está presente. Si deseamos permitir un desplazamiento significativo, entonces podríamos elegir una función de covarianza más aproximada. Ejemplos extremos del comportamiento son la función de covarianza de Ornstein-Uhlenbeck y el cuadrado exponencial donde el primero nunca es diferenciable y el segundo infinitamente diferenciable.

La periodicidad se refiere a inducir patrones periódicos dentro del comportamiento del proceso. Formalmente, esto se logra mapeando la entrada a un vector bidimensional .

Funciones de covarianza habituales

Hay una serie de funciones de covarianza comunes:

- Constante:

- Lineal:

- ruido gaussiano blanco:

- Exponencial al cuadrado:

- Ornstein – Uhlenbeck:

- Materia:

- Periódico:

- Cuadrática racional:

Aquí . El parámetro es la escala de longitud característica del proceso (prácticamente, "qué tan cerca" deben estar dos puntos y deben influirse entre sí de manera significativa), es el delta de Kronecker y la desviación estándar de las fluctuaciones del ruido. Además, es la función de orden de Bessel modificada y es la función gamma evaluada en . Es importante destacar que una función de covarianza complicada se puede definir como una combinación lineal de otras funciones de covarianza más simples para incorporar diferentes conocimientos sobre el conjunto de datos en cuestión.

Claramente, los resultados inferenciales dependen de los valores de los hiperparámetros (por ejemplo, y ) que definen el comportamiento del modelo. Una opción popular para es proporcionar estimaciones máximas a posteriori (MAP) de la misma con algunas elegidas a priori. Si el a priori es casi uniforme, esto equivale a maximizar la probabilidad marginal del proceso; la marginación se realiza sobre los valores de proceso observados . Este enfoque también se conoce como máxima verosimilitud II , maximización de evidencia o Bayes empírico .

Continuidad

Para un proceso gaussiano, la continuidad en la probabilidad es equivalente a la continuidad del cuadrado medio , y la continuidad con la probabilidad uno es equivalente a la continuidad de la muestra . Esto último implica, pero no implica, continuidad en la probabilidad. La continuidad en la probabilidad se mantiene si y solo si la media y la autocovarianza son funciones continuas. Por el contrario, la continuidad de la muestra fue un desafío incluso para los procesos gaussianos estacionarios (como probablemente señaló primero Andrey Kolmogorov ), y más desafiante para los procesos más generales. Como es habitual, por un proceso continuo de muestra se entiende un proceso que admite una modificación continua de muestra .

Caja estacionaria

Para un proceso gaussiano estacionario, algunas condiciones en su espectro son suficientes para la continuidad de la muestra, pero no son necesarias. Una condición necesaria y suficiente, a veces llamada teorema de Dudley-Fernique, involucra la función definida por

(el lado derecho no depende de debido a la estacionariedad). La continuidad de en probabilidad es equivalente a la continuidad de en Cuando la convergencia de a (as ) es demasiado lenta, la continuidad de la muestra de puede fallar. La convergencia de las siguientes integrales importa:

estas dos integrales son iguales de acuerdo con la integración por sustitución. El primer integrando no necesita estar acotado ya que, por lo tanto, la integral puede converger ( ) o divergir ( ). Tomando, por ejemplo, para grande , es decir, para pequeño, se obtiene cuándo y cuándo. En estos dos casos, la función aumenta, pero generalmente no es así. Además, la condición

- existe tal que es monótono en

no se sigue de la continuidad de y las relaciones evidentes (para todos ) y

Teorema 1. Sea continuo y satisfaga Entonces la condición es necesaria y suficiente para la continuidad muestral de

Algo de historia. La suficiencia fue anunciada por Xavier Fernique en 1964, pero la primera prueba fue publicada por Richard M. Dudley en 1967. La necesidad fue demostrada por Michael B. Marcus y Lawrence Shepp en 1970.

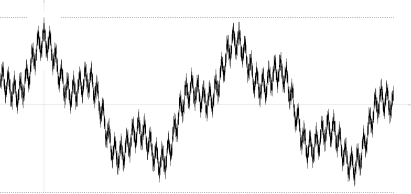

Existen muestras de procesos continuos que violan la condición Un ejemplo encontrado por Marcus y Shepp es una serie lacunar aleatoria de Fourier

donde son variables aleatorias independientes con distribución normal estándar ; las frecuencias son una secuencia de rápido crecimiento; y los coeficientes satisfacen La última relación implica de dónde es casi seguro, lo que asegura la convergencia uniforme de la serie de Fourier casi seguramente, y la continuidad muestral de

Su función de autocovariación

no es monótono en ninguna parte (ver la imagen), así como la función correspondiente

El movimiento browniano como integral de los procesos gaussianos

Un proceso de Wiener (también conocido como movimiento browniano) es la integral de un proceso gaussiano generalizado de ruido blanco . No es estacionario , pero tiene incrementos estacionarios.

El proceso de Ornstein-Uhlenbeck es un proceso gaussiano estacionario .

El puente browniano es (como el proceso de Ornstein-Uhlenbeck) un ejemplo de un proceso gaussiano cuyos incrementos no son independientes .

El movimiento browniano fraccional es un proceso gaussiano cuya función de covarianza es una generalización de la del proceso de Wiener.

Ley cero-uno de Driscoll

La ley cero-uno de Driscoll es un resultado que caracteriza las funciones de muestra generadas por un proceso gaussiano.

Sea un proceso gaussiano de media cero con función de covarianza definida no negativa . Sea un espacio de Hilbert del núcleo en reproducción con un núcleo definido positivo .

Luego

- ,

donde y son las matrices de covarianza de todos los posibles pares de puntos, implica

- .

Y lo que es más,

implica

- .

Esto tiene implicaciones significativas cuando , como

- .

Como tal, casi todas las rutas de muestra de un proceso gaussiano de media cero con un núcleo definido positivo estarán fuera del espacio de Hilbert .

Procesos gaussianos linealmente restringidos

Para muchas aplicaciones de interés, ya se proporciona algún conocimiento preexistente sobre el sistema en cuestión. Considérese, por ejemplo, el caso en el que la salida del proceso gaussiano corresponde a un campo magnético; aquí, el campo magnético real está limitado por las ecuaciones de Maxwell y sería deseable una forma de incorporar esta restricción en el formalismo del proceso gaussiano, ya que esto probablemente mejoraría la precisión del algoritmo.

Ya existe un método sobre cómo incorporar restricciones lineales en los procesos gaussianos:

Considere la función de salida (con valor vectorial) que se sabe que obedece a la restricción lineal ( es decir, es un operador lineal)

Entonces la restricción puede cumplirse eligiendo , donde se modela como un proceso gaussiano, y encontrando st

Dado y utilizando el hecho de que los procesos gaussianos están cerrados bajo transformaciones lineales, el proceso gaussiano para obedecer la restricción se convierte en

Por lo tanto, las restricciones lineales se pueden codificar en la función de covarianza y media de un proceso gaussiano.

Aplicaciones

Se puede utilizar un proceso gaussiano como distribución de probabilidad previa sobre funciones en la inferencia bayesiana . Dado cualquier conjunto de N puntos en el dominio deseado de sus funciones, tome una Gaussiana multivariante cuyo parámetro de matriz de covarianza sea la matriz de Gram de sus N puntos con algún kernel deseado , y una muestra de esa Gaussiana. Para la solución del problema de predicción de múltiples salidas, se desarrolló la regresión del proceso gaussiano para la función con valores vectoriales. En este método, se construye una covarianza 'grande', que describe las correlaciones entre todas las variables de entrada y salida tomadas en N puntos en el dominio deseado. Este enfoque se elaboró en detalle para los procesos gaussianos con valores matriciales y se generalizó a procesos con 'colas más pesadas' como los procesos t de Student .

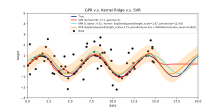

La inferencia de valores continuos con un proceso gaussiano previo se conoce como regresión del proceso gaussiano o kriging ; extender la regresión del proceso gaussiano a múltiples variables objetivo se conoce como cokriging . Los procesos gaussianos son, por tanto, útiles como una poderosa herramienta de interpolación multivariante no lineal .

Los procesos gaussianos también se pueden utilizar en el contexto de modelos mixtos de expertos, por ejemplo. El fundamento fundamental de tal marco de aprendizaje consiste en la suposición de que un mapeo dado no puede ser capturado bien por un solo modelo de proceso gaussiano. En cambio, el espacio de observación se divide en subconjuntos, cada uno de los cuales se caracteriza por una función de mapeo diferente; cada uno de estos se aprende a través de un componente de proceso gaussiano diferente en la mezcla postulada.

Predicción del proceso gaussiano o Kriging

Cuando se trata de un problema de regresión de proceso gaussiano general (Kriging), se supone que para un proceso gaussiano observado en coordenadas , el vector de valores es solo una muestra de una distribución gaussiana multivariada de dimensión igual al número de coordenadas observadas . Por lo tanto, bajo el supuesto de una distribución de media cero , donde es la matriz de covarianza entre todos los pares posibles para un conjunto dado de hiperparámetros θ . Como tal, la probabilidad marginal logarítmica es:

y maximizar esta probabilidad marginal hacia θ proporciona la especificación completa del proceso gaussiano f . En este punto, se puede notar brevemente que el primer término corresponde a un término de penalización por la falla de un modelo de ajustar los valores observados y el segundo término a un término de penalización que aumenta proporcionalmente a la complejidad de un modelo. Habiendo especificado θ , hacer predicciones sobre valores no observados en las coordenadas x * es entonces solo una cuestión de extraer muestras de la distribución predictiva donde la estimación media posterior A se define como

y la estimación de la varianza posterior B se define como:

donde es la covarianza entre la nueva coordenada de estimación x * y todas las demás coordenadas observadas x para un vector de hiperparámetro dado θ , y se definen como antes y es la varianza en el punto x * según lo dicta θ . Es importante señalar que prácticamente la estimación media posterior (la "estimación puntual") es solo una combinación lineal de las observaciones ; de manera similar, la varianza de es realmente independiente de las observaciones . Un cuello de botella conocido en la predicción de procesos gaussianos es que la complejidad computacional de la evaluación de inferencia y verosimilitud es cúbica en el número de puntos | x |, y como tal puede volverse inviable para conjuntos de datos más grandes. Los trabajos en procesos gaussianos dispersos, que generalmente se basan en la idea de construir un conjunto representativo para el proceso dado f , tratan de eludir este problema. El método kriging se puede utilizar en el nivel latente de un modelo de efectos mixtos no lineal para una predicción funcional espacial: esta técnica se llama kriging latente.

Redes neuronales bayesianas como procesos gaussianos

Las redes neuronales bayesianas son un tipo particular de red bayesiana que resulta de tratar probabilísticamente los modelos de redes neuronales artificiales y el aprendizaje profundo , y asignar una distribución previa a sus parámetros . La computación en redes neuronales artificiales generalmente se organiza en capas secuenciales de neuronas artificiales . La cantidad de neuronas en una capa se denomina ancho de capa. A medida que el ancho de la capa crece, muchas redes neuronales bayesianas se reducen a un proceso gaussiano con un núcleo compositivo de forma cerrada . Este proceso gaussiano se denomina proceso gaussiano de red neuronal (NNGP). Permite que las predicciones de las redes neuronales bayesianas se evalúen de manera más eficiente y proporciona una herramienta analítica para comprender los modelos de aprendizaje profundo .

Problemas computacionales

En aplicaciones prácticas, los modelos de proceso gaussianos a menudo se evalúan en una cuadrícula que conduce a distribuciones normales multivariadas. El uso de estos modelos para la predicción o la estimación de parámetros utilizando la máxima verosimilitud requiere evaluar una densidad gaussiana multivariante, que implica calcular el determinante y la inversa de la matriz de covarianza. Ambas operaciones tienen una complejidad computacional cúbica, lo que significa que incluso para cuadrículas de tamaños modestos, ambas operaciones pueden tener un costo computacional prohibitivo. Este inconveniente condujo al desarrollo de múltiples métodos de aproximación .

Ver también

- Estadísticas lineales de Bayes

- Interpretación bayesiana de regularización

- Kriging

- Campo libre gaussiano

- Proceso de Gauss-Markov

- Kriging mejorado con gradiente (GEK)

- Proceso t de Student

Referencias

enlaces externos

- El sitio web de procesos gaussianos, incluido el texto de los procesos gaussianos para el aprendizaje automático de Rasmussen y Williams

- Una suave introducción a los procesos gaussianos

- Una revisión de los campos aleatorios gaussianos y las funciones de correlación

- Aprendizaje por refuerzo eficiente mediante procesos gaussianos

Software

- GPML: una caja de herramientas integral de Matlab para regresión y clasificación GP

- STK: una pequeña caja de herramientas (Matlab / Octave) para modelado de Kriging y GP

- Módulo Kriging en el marco UQLab (Matlab)

- Función Matlab / Octave para campos gaussianos estacionarios

- Yelp MOE: un motor de optimización de caja negra que utiliza el proceso de aprendizaje gaussiano

- ooDACE : una caja de herramientas flexible de Kriging Matlab orientada a objetos.

- GPstuff: caja de herramientas de proceso gaussiano para Matlab y Octave

- GPy: un marco de procesos gaussianos en Python

- GSTools: una caja de herramientas geoestadísticas, que incluye la regresión del proceso gaussiano, escrita en Python

- Demostración interactiva de regresión del proceso gaussiano

- Biblioteca básica de procesos gaussianos escrita en C ++ 11

- scikit-learn : una biblioteca de aprendizaje automático para Python que incluye regresión y clasificación de procesos gaussianos

- [1] - El kit de herramientas Kriging (KriKit) se desarrolla en el Instituto de Biociencias y Geociencias 1 (IBG-1) de Forschungszentrum Jülich (FZJ)

![{\ Displaystyle \ operatorname {var} [X (t)] = \ operatorname {E} [| X (t) - \ operatorname {E} [X (t)] | ^ {2}] <\ infty \ quad { \ text {para todos}} t \ in T}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ae643c93ad0f56457881fa60e3bdae082fd5e73a)

![{\ displaystyle [0, \ varepsilon]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/09b79b1e11f2a6c9b36a919ddbbf91204fe7a1df)

![{\ Displaystyle \ lim _ {n \ to \ infty} \ operatorname {tr} [K_ {n} R_ {n} ^ {- 1}] <\ infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c62de62758eb883e4255dab480943abdebdb00d9)

![{\ Displaystyle \ Pr [f \ in {\ mathcal {H}} (R)] = 1}](https://wikimedia.org/api/rest_v1/media/math/render/svg/38ca6ca8c04250e643221318bc2b55241112519e)

![{\ Displaystyle \ lim _ {n \ to \ infty} \ operatorname {tr} [K_ {n} R_ {n} ^ {- 1}] = \ infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e133d11ae8a4dc2825314c86ec4c86df1aabb0fe)

![{\ Displaystyle \ Pr [f \ in {\ mathcal {H}} (R)] = 0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4cb02319fc30c845fd10102601b63961f296f931)

![{\ Displaystyle \ lim _ {n \ to \ infty} \ operatorname {tr} [R_ {n} R_ {n} ^ {- 1}] = \ lim _ {n \ to \ infty} \ operatorname {tr} [ I] = \ lim _ {n \ to \ infty} n = \ infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/70d34626fb759d05905dc20be06ded12144368c5)