Análisis exploratorio de datos - Exploratory data analysis

| Parte de una serie sobre estadísticas |

| Visualización de datos |

|---|

| Dimensiones principales |

| Cifras importantes |

| Tipos de gráficos de información |

| Temas relacionados |

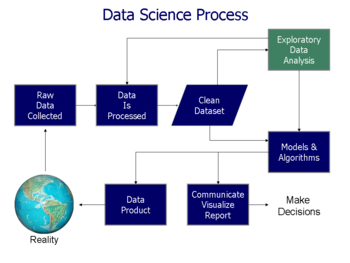

En estadística , el análisis exploratorio de datos es un enfoque de análisis de conjuntos de datos para resumir sus principales características, a menudo utilizando gráficos estadísticos y otros métodos de visualización de datos . Se puede usar o no un modelo estadístico , pero principalmente EDA es para ver qué nos pueden decir los datos más allá del modelado formal o la tarea de prueba de hipótesis. El análisis exploratorio de datos ha sido promovido por John Tukey desde 1970 para alentar a los estadísticos a explorar los datos y posiblemente formular hipótesis que podrían conducir a nuevos experimentos y recopilación de datos. EDA es diferente del análisis de datos inicial (IDA) , que se enfoca más estrictamente en verificar los supuestos requeridos para el ajuste del modelo y la prueba de hipótesis, y manejar los valores faltantes y hacer transformaciones de variables según sea necesario. EDA abarca IDA.

Visión general

Tukey definió el análisis de datos en 1961 como: "Procedimientos para analizar datos, técnicas para interpretar los resultados de dichos procedimientos, formas de planificar la recopilación de datos para hacer su análisis más fácil, más preciso o más exacto, y toda la maquinaria y resultados de ( matemáticas) estadísticas que se aplican al análisis de datos ".

La defensa de EDA por parte de Tukey alentó el desarrollo de paquetes de computación estadística , especialmente S en Bell Labs . El lenguaje de programación S inspiró a los sistemas S-PLUS y R . Esta familia de entornos de computación estadística presentaba capacidades de visualización dinámica muy mejoradas, lo que permitió a los estadísticos identificar valores atípicos , tendencias y patrones en los datos que merecían un estudio más a fondo.

La EDA de Tukey se relacionó con otros dos desarrollos en la teoría estadística : estadísticas robustas y estadísticas no paramétricas , las cuales intentaron reducir la sensibilidad de las inferencias estadísticas a los errores en la formulación de modelos estadísticos . Tukey promovió el uso de resumen de cinco números de datos numéricos - los dos extremos ( máximo y mínimo ), la mediana y los cuartiles - porque estas medianas y cuartiles, al ser funciones de la distribución empírica, están definidas para todas las distribuciones, a diferencia de la media y desviación estándar ; además, los cuartiles y la mediana son más robustos a las distribuciones sesgadas o de cola pesada que los resúmenes tradicionales (la media y la desviación estándar). Los paquetes S , S-PLUS y R incluían rutinas que usaban estadísticas de remuestreo , como Quenouille y Tukey's jackknife y Efron 's bootstrap , que son no paramétricas y robustas (para muchos problemas).

El análisis de datos exploratorios, las estadísticas sólidas, las estadísticas no paramétricas y el desarrollo de lenguajes de programación estadística facilitaron el trabajo de los estadísticos sobre problemas científicos y de ingeniería. Dichos problemas incluían la fabricación de semiconductores y la comprensión de las redes de comunicaciones, lo que preocupaba a Bell Labs. Estos desarrollos estadísticos, todos defendidos por Tukey, fueron diseñados para complementar la teoría analítica de probar hipótesis estadísticas , particularmente el énfasis de la tradición laplaciana en las familias exponenciales .

Desarrollo

John W. Tukey escribió el libro Exploratory Data Analysis en 1977. Tukey sostuvo que se puso demasiado énfasis en la estadística en la prueba de hipótesis estadísticas (análisis de datos confirmatorios); era necesario poner más énfasis en el uso de datos para sugerir hipótesis a probar. En particular, sostuvo que confundir los dos tipos de análisis y emplearlos en el mismo conjunto de datos puede conducir a un sesgo sistemático debido a los problemas inherentes a la prueba de hipótesis sugeridas por los datos .

Los objetivos de EDA son:

- Sugerir hipótesis sobre las causas de los fenómenos observados

- Evaluar los supuestos en los que se basará la inferencia estadística

- Apoyar la selección de herramientas y técnicas estadísticas adecuadas.

- Proporcionar una base para una mayor recopilación de datos a través de encuestas o experimentos.

Se han adoptado muchas técnicas de EDA en la minería de datos . También se les enseña a los jóvenes estudiantes como una forma de introducirlos en el pensamiento estadístico.

Técnicas y herramientas

Hay una serie de herramientas que son útiles para EDA, pero EDA se caracteriza más por la actitud que por técnicas particulares.

Las técnicas gráficas típicas utilizadas en EDA son:

- Diagrama de caja

- Histograma

- Gráfico multivariable

- Tabla de ejecutar

- diagrama de Pareto

- Gráfico de dispersión

- Diagrama de tallo y hojas

- Coordenadas paralelas

- Razón de probabilidades

- Búsqueda de proyección dirigida

- Métodos de visualización basados en glifos como caras PhenoPlot y Chernoff

- Métodos de proyección como grand tour, tour guiado y tour manual.

- Versiones interactivas de estas parcelas.

Reducción de dimensionalidad :

- Escalamiento multidimensional

- Análisis de componentes principales (PCA)

- PCA multilineal

- Reducción de dimensionalidad no lineal (NLDR)

- Iconografía de correlaciones

Las técnicas cuantitativas típicas son:

Historia

Muchas ideas de EDA se remontan a autores anteriores, por ejemplo:

- Francis Galton enfatizó las estadísticas de orden y los cuantiles .

- Arthur Lyon Bowley usó precursores de la raíz y el resumen de cinco números (Bowley en realidad usó un " resumen de siete cifras ", incluidos los extremos, deciles y cuartiles , junto con la mediana; consulte su Manual elemental de estadística (3a ed., 1920 ), p. 62 - define "el máximo y mínimo, mediana, cuartiles y dos deciles" como las "siete posiciones").

- Andrew Ehrenberg articuló una filosofía de reducción de datos (ver su libro del mismo nombre).

El curso de la Universidad Abierta Estadística en la Sociedad (MDST 242), tomó las ideas anteriores y las fusionó con el trabajo de Gottfried Noether , que introdujo la inferencia estadística mediante el lanzamiento de monedas y la prueba de la mediana .

Ejemplo

Los hallazgos de EDA son ortogonales a la tarea de análisis principal. Para ilustrar, considere un ejemplo de Cook et al. donde la tarea de análisis es encontrar las variables que mejor predicen la propina que un comensal le dará al camarero. Las variables disponibles en los datos recopilados para esta tarea son: monto de la propina, factura total, sexo del pagador, sección de fumadores / no fumadores, hora del día, día de la semana y tamaño de la fiesta. La tarea de análisis principal se aborda ajustando un modelo de regresión donde la tasa de propina es la variable de respuesta. El modelo ajustado es

- ( tasa de propina ) = 0,18 - 0,01 × (tamaño del grupo)

que dice que a medida que el tamaño de la cena aumenta en una persona (lo que genera una factura más alta), la tasa de propina disminuirá en un 1%.

Sin embargo, la exploración de los datos revela otras características interesantes no descritas por este modelo.

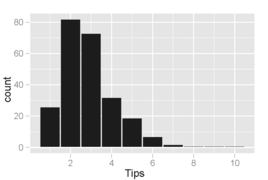

Histograma de montos de propina donde los contenedores cubren incrementos de $ 0.10. Es visible un fenómeno interesante: los picos ocurren en las cantidades de dólares enteros y de medio dólar, lo que se debe a que los clientes eligen números redondos como propinas. Este comportamiento también es común a otro tipo de compras, como la gasolina.

Diagrama de dispersión de propinas frente a factura. Los puntos debajo de la línea corresponden a propinas que son más bajas de lo esperado (para ese monto de la factura) y los puntos por encima de la línea son más altos de lo esperado. Podríamos esperar ver una asociación lineal estrecha y positiva, pero en su lugar ver una variación que aumenta con la cantidad de propina . En particular, hay más puntos alejados de la línea en la parte inferior derecha que en la parte superior izquierda, lo que indica que hay más clientes muy baratos que muy generosos.

Diagrama de dispersión de propinas frente a factura separada por sexo del pagador y estado de la sección de fumadores. Las fiestas de fumadores tienen mucha más variabilidad en las propinas que dan. Los hombres tienden a pagar las (pocas) facturas más altas, y las mujeres no fumadoras tienden a dar propinas muy consistentes (con tres notables excepciones que se muestran en la muestra).

Lo que se aprende de los gráficos es diferente de lo que ilustra el modelo de regresión, aunque el experimento no fue diseñado para investigar ninguna de estas otras tendencias. Los patrones encontrados al explorar los datos sugieren hipótesis sobre las propinas que pueden no haberse anticipado de antemano y que podrían conducir a experimentos de seguimiento interesantes en los que las hipótesis se establezcan y prueben formalmente mediante la recopilación de nuevos datos.

Software

- JMP , un paquete EDA de SAS Institute .

- KNIME , Konstanz Information Miner: plataforma de exploración de datos de código abierto basada en Eclipse.

- Minitab , un paquete de estadísticas generales y EDA ampliamente utilizado en entornos industriales y corporativos.

- Orange , un paquete de software de aprendizaje automático y minería de datos de código abierto.

- Python , un lenguaje de programación de código abierto ampliamente utilizado en minería de datos y aprendizaje automático.

- R , un lenguaje de programación de código abierto para gráficos y computación estadística. Junto con Python, uno de los lenguajes más populares para la ciencia de datos.

- TinkerPlots un software EDA para estudiantes de primaria y secundaria superiores.

- Weka es un paquete de minería de datos de código abierto que incluye herramientas de visualización y EDA, como la búsqueda de proyección dirigida .

Ver también

- Cuarteto de Anscombe , sobre la importancia de la exploración

- Dragado de datos

- Analítica predictiva

- Análisis de datos estructurados (estadísticas)

- Análisis de frecuencia de configuración

- Estadísticas descriptivas

Referencias

Bibliografía

- Andrienko, N & Andrienko, G (2005) Análisis exploratorio de datos espaciales y temporales. Un enfoque sistemático . Saltador. ISBN 3-540-25994-5

- Cook, D. y Swayne, DF (con A. Buja, D. Temple Lang, H. Hofmann, H. Wickham, M. Lawrence) (12 de diciembre de 2007). Gráficos interactivos y dinámicos para análisis de datos: con R y GGobi . Saltador. ISBN 9780387717616.CS1 maint: varios nombres: lista de autores ( enlace )

- Hoaglin, DC; Mosteller, F y Tukey, John Wilder (Eds) (1985). Explorando tablas de datos, tendencias y formas . ISBN 978-0-471-09776-1.CS1 maint: varios nombres: lista de autores ( enlace ) CS1 maint: texto adicional: lista de autores ( enlace )

- Hoaglin, DC; Mosteller, F y Tukey, John Wilder (Eds) (1983). Comprensión del análisis de datos robusto y exploratorio . ISBN 978-0-471-09777-8.CS1 maint: varios nombres: lista de autores ( enlace ) CS1 maint: texto adicional: lista de autores ( enlace )

- Inselberg, Alfred (2009). Coordenadas paralelas: geometría visual multidimensional y sus aplicaciones . Londres Nueva York: Springer. ISBN 978-0-387-68628-8.

- Leinhardt, G., Leinhardt, S., Análisis de datos exploratorios: nuevas herramientas para el análisis de datos empíricos , Revisión de la investigación en educación, vol. 8, 1980 (1980), págs. 85-157.

- Martínez, WL ; Martinez, AR y Solka, J. (2010). Análisis exploratorio de datos con MATLAB, segunda edición . Chapman y Hall / CRC. ISBN 9781439812204.

- Theus, M., Urbanek, S. (2008), Gráficos interactivos para el análisis de datos: principios y ejemplos, CRC Press, Boca Raton, FL, ISBN 978-1-58488-594-8

- Tucker, L; MacCallum, R. (1993). Análisis factorial exploratorio . [1] .

- Tukey, John Wilder (1977). Análisis de datos exploratorios . Addison-Wesley. ISBN 978-0-201-07616-5.

- Velleman, PF; Hoaglin, DC (1981). Aplicaciones, conceptos básicos y computación del análisis de datos exploratorios . ISBN 978-0-87150-409-8.

- Young, FW Valero-Mora, P. y Friendly M. (2006) Estadísticas visuales: Ver sus datos con gráficos interactivos dinámicos . Wiley ISBN 978-0-471-68160-1

- Jambu M. (1991) Análisis de datos exploratorio y multivariado . Prensa académica ISBN 0123800900

- SHC DuToit, AGW Steyn, RH Stumpf (1986) Análisis gráfico de datos exploratorios . Springer ISBN 978-1-4612-9371-2