Moderación (estadísticas) - Moderation (statistics)

En estadística y análisis de regresión , la moderación ocurre cuando la relación entre dos variables depende de una tercera variable. La tercera variable se denomina variable moderadora o simplemente moderador . El efecto de una variable moderadora se caracteriza estadísticamente como una interacción ; es decir, una variable categórica (por ejemplo, sexo, etnia, clase) o cuantitativa (por ejemplo, nivel de recompensa) que afecta la dirección y / o fuerza de la relación entre variables dependientes e independientes . Específicamente dentro de un marco de análisis correlacional , un moderador es una tercera variable que afecta la correlación de orden cero entre otras dos variables, o el valor de la pendiente de la variable dependiente sobre la variable independiente. En términos de análisis de varianza (ANOVA), un efecto moderador básico se puede representar como una interacción entre una variable focal independiente y un factor que especifica las condiciones adecuadas para su funcionamiento.

Ejemplo

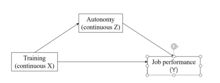

El análisis de moderación en las ciencias del comportamiento implica el uso de análisis de regresión lineal múltiple o modelos causales . Para cuantificar el efecto de una variable moderadora en análisis de regresión múltiple, regresando la variable aleatoria Y sobre X , se agrega un término adicional al modelo. Este término es la interacción entre X y la variable moderadora propuesta.

Así, para una respuesta Y y dos variables x 1 y una variable moderadora x 2 ,:

En este caso, el papel de x 2 como variable moderadora se logra evaluando b 3 , el parámetro estimado para el término de interacción. Consulte la regresión lineal para obtener información sobre la evaluación estadística de las estimaciones de los parámetros en los análisis de regresión.

Multicolinealidad en regresión moderada

En el análisis de regresión moderado, se calcula un nuevo predictor de interacción ( ). Sin embargo, el nuevo término de interacción se correlacionará con los dos términos de efectos principales utilizados para calcularlo. Este es el problema de la multicolinealidad en regresión moderada. La multicolinealidad tiende a hacer que los coeficientes se estimen con errores estándar más altos y, por lo tanto, con una mayor incertidumbre.

El centrado en la media (restando las puntuaciones brutas de la media) puede reducir la multicolinealidad, lo que da como resultado coeficientes de regresión más interpretables. Sin embargo, no afecta el ajuste general del modelo.

Sondeo post-hoc de interacciones

Al igual que el análisis de efecto principal simple en ANOVA, en el sondeo post-hoc de interacciones en regresión, estamos examinando la pendiente simple de una variable independiente en los valores específicos de la otra variable independiente. A continuación se muestra un ejemplo de prueba de interacciones bidireccionales. En lo que sigue a la ecuación de regresión con dos variables A y B y un término de interacción A * B,

será considerado.

Dos variables independientes categóricas

Si ambas variables independientes son variables categóricas, podemos analizar los resultados de la regresión para una variable independiente a un nivel específico de la otra variable independiente. Por ejemplo, suponga que tanto A como B son variables simples codificadas como ficticias (0,1), y que A representa la etnia (0 = americanos europeos, 1 = asiáticos del este) y B representa la condición en el estudio (0 = control, 1 = experimental). Luego, el efecto de interacción muestra si el efecto de la condición sobre la variable dependiente Y es diferente para los estadounidenses de origen europeo y los asiáticos orientales y si el efecto de la condición étnica es diferente para las dos condiciones. El coeficiente de A muestra el efecto de la etnia sobre Y para la condición de control, mientras que el coeficiente de B muestra el efecto de imponer la condición experimental para los participantes europeos americanos.

Para probar si hay alguna diferencia significativa entre los europeos estadounidenses y los asiáticos orientales en la condición experimental, simplemente podemos ejecutar el análisis con la variable de condición codificada al revés (0 = experimental, 1 = control), de modo que el coeficiente de origen étnico represente la efecto de la etnia sobre Y en la condición experimental. De manera similar, si queremos ver si el tratamiento tiene un efecto en los participantes de Asia oriental, podemos codificar al revés la variable de origen étnico (0 = asiáticos orientales, 1 = americanos europeos).

Una variable independiente categórica y una continua

Si la primera variable independiente es una variable categórica (por ejemplo, género) y la segunda es una variable continua (por ejemplo, puntuaciones en la Escala de satisfacción con la vida (SWLS)), entonces b 1 representa la diferencia en la variable dependiente entre hombres y mujeres cuando la vida la satisfacción es cero. Sin embargo, una puntuación cero en la escala de satisfacción con la vida no tiene sentido, ya que el rango de la puntuación es de 7 a 35. Aquí es donde entra en juego el centrado. Si restamos la media de la puntuación SWLS para la muestra de la puntuación de cada participante, el la media de la puntuación SWLS centrada resultante es cero. Cuando se vuelve a ejecutar el análisis, b 1 ahora representa la diferencia entre hombres y mujeres en el nivel medio de la puntuación SWLS de la muestra.

Cohen y col. (2003) recomendaron usar lo siguiente para probar el efecto simple del género en la variable dependiente (Y) en tres niveles de la variable independiente continua: alto (una desviación estándar por encima de la media), moderado (en la media) y bajo ( una desviación estándar por debajo de la media). Si las puntuaciones de la variable continua no están estandarizadas, se pueden calcular estos tres valores sumando o restando una desviación estándar de las puntuaciones originales; si los puntajes de la variable continua están estandarizados, se pueden calcular los tres valores de la siguiente manera: alto = el puntaje estandarizado menos 1, moderado (media = 0), bajo = el puntaje estandarizado más 1. Entonces se pueden explorar los efectos del género en la variable dependiente ( Y ) en los niveles alto, moderado y bajo de la puntuación SWLS. Al igual que con dos variables independientes categóricas, b 2 representa el efecto de la puntuación SWLS sobre la variable dependiente para las mujeres. Mediante la codificación inversa de la variable de género, se puede obtener el efecto de la puntuación SWLS en la variable dependiente para los hombres.

Codificación en regresión moderada

Al tratar variables categóricas como grupos étnicos y tratamientos experimentales como variables independientes en regresión moderada, es necesario codificar las variables de modo que cada variable de código represente una configuración específica de la variable categórica. Hay tres formas básicas de codificación: codificación de variable ficticia, codificación de efectos y codificación de contraste. A continuación se muestra una introducción a estos sistemas de codificación.

La codificación ficticia se utiliza cuando se tiene un grupo de referencia o una condición en particular (por ejemplo, un grupo de control en el experimento) que se va a comparar con cada uno de los otros grupos experimentales. En este caso, la intersección es la media del grupo de referencia y cada uno de los coeficientes de regresión no estandarizados es la diferencia en la variable dependiente entre uno de los grupos de tratamiento y la media del grupo de referencia (o grupo de control). Este sistema de codificación es similar al análisis ANOVA y es apropiado cuando los investigadores tienen un grupo de referencia específico y quieren comparar cada uno de los otros grupos con él.

La codificación de efectos se utiliza cuando uno no tiene una comparación o un grupo de control en particular y no tiene contrastes ortogonales planificados. La intersección es la gran media (la media de todas las condiciones). El coeficiente de regresión es la diferencia entre la media de un grupo y la media de todas las medias del grupo (por ejemplo, la media del grupo A menos la media de todos los grupos). Este sistema de codificación es apropiado cuando los grupos representan categorías naturales.

La codificación de contraste se utiliza cuando se tiene una serie de contrastes ortogonales o comparaciones de grupos que se van a investigar. En este caso, la intersección es la media no ponderada de las medias del grupo individual. El coeficiente de regresión no estandarizado representa la diferencia entre la media no ponderada de las medias de un grupo (A) y la media no ponderada de otro grupo (B), donde A y B son dos conjuntos de grupos en el contraste. Este sistema de codificación es apropiado cuando los investigadores tienen una hipótesis a priori sobre las diferencias específicas entre las medias de los grupos.

Dos variables independientes continuas

Si las dos variables independientes son continuas, es útil para la interpretación de cualquiera de centro o estandarizar las variables independientes, X y Z . (Centrar implica restar el puntaje promedio de la muestra general del puntaje original; la estandarización hace lo mismo seguido de dividir por la desviación estándar de la muestra general). Al centrar o estandarizar las variables independientes, el coeficiente de X o Z se puede interpretar como el efecto de esa variable en Y al nivel medio de la otra variable independiente.

Para probar el efecto de interacción, a menudo es útil graficar el efecto de X sobre Y en valores bajos y altos de Z (algunas personas prefieren graficar también el efecto en valores moderados de Z , pero esto no es necesario). A menudo, los valores de Z que están una desviación estándar por encima y por debajo de la media se eligen para esto, pero se puede usar cualquier valor sensible (y en algunos casos hay valores más significativos para elegir). La trama se dibuja generalmente mediante la evaluación de los valores de Y para valores altos y bajos tanto de X y Z , y la creación de dos líneas para representar el efecto de X en Y en los dos valores de Z . A veces esto se complementa mediante análisis de pendiente simple, que determina si el efecto de X en Y es estadísticamente significativa en valores particulares de Z . Existen varias herramientas basadas en Internet para ayudar a los investigadores a trazar e interpretar estas interacciones bidireccionales.

Interacciones de nivel superior

Los principios para las interacciones bidireccionales se aplican cuando queremos explorar interacciones de tres vías o de nivel superior. Por ejemplo, si tenemos una interacción de tres vías entre A , B y C , la ecuación de regresión será la siguiente:

Efectos espurios de orden superior

Vale la pena señalar que la confiabilidad de los términos de orden superior depende de la confiabilidad de los términos de orden inferior. Por ejemplo, si la fiabilidad de la variable A es 0,70 y la fiabilidad de la variable B es 0,80, entonces la fiabilidad de la variable de interacción A * B es 0,70 × 0,80 = 0,56. En este caso, la baja fiabilidad del término de interacción conduce a una baja potencia; por lo tanto, es posible que no podamos encontrar los efectos de interacción entre A y B que realmente existen. La solución para este problema es utilizar medidas altamente confiables para cada variable independiente.

Otra advertencia para interpretar los efectos de interacción es que cuando la variable A y la variable B están altamente correlacionadas, entonces el término A * B estará altamente correlacionado con la variable omitida A 2 ; en consecuencia, lo que parece ser un efecto de moderación significativo podría ser en realidad un efecto no lineal significativo de A solo. Si este es el caso, vale la pena probar un modelo de regresión no lineal agregando términos no lineales en variables individuales en el análisis de regresión moderada para ver si las interacciones siguen siendo significativas. Si el efecto de interacción A * B sigue siendo significativo, tendremos más confianza al decir que efectivamente existe un efecto de moderación; sin embargo, si el efecto de interacción deja de ser significativo después de agregar el término no lineal, tendremos menos certeza acerca de la existencia de un efecto de moderación y se preferirá el modelo no lineal porque es más parsimonioso.

Los análisis de regresión moderada también tienden a incluir variables adicionales, que se conceptualizan como covariables sin interés. Sin embargo, la presencia de estas covariables puede inducir efectos espurios cuando (1) la covariable (C) está correlacionada con una de las variables primarias de interés (por ejemplo, variable A o B), o (2) cuando la covariable en sí es un moderador de la correlación entre A o B con Y. La solución es incluir términos de interacción adicionales en el modelo, para la interacción entre cada factor de confusión y las variables primarias de la siguiente manera:

Ver también

Referencias

- Hayes, AF y Matthes, J. (2009). "Procedimientos computacionales para sondear interacciones en OLS y regresión logística: implementaciones de SPSS y SAS". Métodos de investigación del comportamiento, vol. 41, págs. 924–936.