Agente inteligente - Intelligent agent

En inteligencia artificial , un agente inteligente ( IA ) es todo aquello que percibe su entorno, realiza acciones de forma autónoma para lograr objetivos y puede mejorar su desempeño con el aprendizaje o puede utilizar el conocimiento . Pueden ser simples o complejos: un termostato se considera un ejemplo de un agente inteligente, al igual que un ser humano, al igual que cualquier sistema que cumpla con la definición, como una empresa , un estado o un bioma .

Los principales libros de texto de IA definen la "inteligencia artificial" como el "estudio y diseño de agentes inteligentes", una definición que considera que el comportamiento dirigido a objetivos es la esencia de la inteligencia. Los agentes dirigidos a objetivos también se describen utilizando un término tomado de la economía , " agente racional ".

Un agente tiene una "función objetivo" que encapsula todos los objetivos de la AI. Dicho agente está diseñado para crear y ejecutar cualquier plan que, una vez completado, maximice el valor esperado de la función objetivo. Por ejemplo, un agente de aprendizaje reforzado tiene una "función de recompensa" que permite a los programadores dar forma al comportamiento deseado de la IA, y el comportamiento de un algoritmo evolutivo está conformado por una "función de aptitud".

Los agentes inteligentes en la inteligencia artificial están estrechamente relacionados con los agentes en la economía , y las versiones del paradigma del agente inteligente se estudian en la ciencia cognitiva , la ética , la filosofía de la razón práctica , así como en muchos modelos sociocognitivos interdisciplinarios y simulaciones sociales por computadora .

Los agentes inteligentes a menudo se describen esquemáticamente como un sistema funcional abstracto similar a un programa de computadora. Las descripciones abstractas de agentes inteligentes se denominan agentes inteligentes abstractos ( AIA ) para distinguirlos de sus implementaciones del mundo real. Un agente inteligente autónomo está diseñado para funcionar en ausencia de intervención humana. Los agentes inteligentes también están estrechamente relacionados con los agentes de software (un programa informático autónomo que realiza tareas en nombre de los usuarios).

Definición de inteligencia artificial

La informática define la investigación de la IA como el estudio de agentes inteligentes . El principal libro de texto de IA define un "agente" como:

- "Cualquier cosa que pueda verse como percibiendo su entorno a través de sensores y actuando sobre ese entorno a través de actuadores"

define un "agente racional" como:

- "Un agente que actúa para maximizar el valor esperado de una medida de desempeño basada en la experiencia y el conocimiento pasados".

y define el campo de la investigación de la "inteligencia artificial" como:

- "El estudio y diseño de agentes racionales"

Kaplan y Haenlein dan una definición similar de IA: "La capacidad de un sistema para interpretar correctamente datos externos, aprender de dichos datos y utilizar esos aprendizajes para lograr metas y tareas específicas a través de una adaptación flexible".

Padgham y Winikoff (2005) coinciden en que un agente inteligente está situado en un entorno y responde (de manera oportuna, aunque no necesariamente en tiempo real) a los cambios del entorno. Sin embargo, los agentes inteligentes también deben perseguir objetivos de manera proactiva de una manera flexible y sólida. Los desiderata opcionales incluyen que el agente sea racional y que el agente sea capaz de realizar un análisis de creencia-deseo-intención .

Ventajas de esta definición

Filosóficamente, evita varias líneas de crítica. A diferencia de la prueba de Turing , no se refiere a la inteligencia humana de ninguna manera. Por lo tanto, no hay necesidad de discutir si es inteligencia "real" versus inteligencia "simulada" (es decir, inteligencia "sintética" versus inteligencia "artificial"), y no indica que dicha máquina tenga mente , conciencia o comprensión verdadera (es decir, no implica la " hipótesis fuerte de la IA " de John Searle ). Tampoco intenta trazar una línea divisoria nítida entre los comportamientos que son "inteligentes" y los comportamientos que son "no inteligentes"; los programas solo necesitan medirse en términos de su función objetiva.

Más importante aún, tiene una serie de ventajas prácticas que han ayudado a hacer avanzar la investigación de la IA. Proporciona una forma confiable y científica de probar programas; los investigadores pueden comparar directamente o incluso combinar diferentes enfoques para problemas aislados, preguntando qué agente es mejor para maximizar una "función objetivo" dada. También les da un lenguaje común para comunicarse con otros campos, como la optimización matemática (que se define en términos de "objetivos") o la economía (que utiliza la misma definición de " agente racional ").

Función objetiva

Un agente al que se le asigna una "función de objetivo" explícita se considera más inteligente si realiza de manera constante acciones que maximicen con éxito su función de objetivo programada. El objetivo puede ser simple ("1 si el IA gana un juego de Go , 0 en caso contrario") o complejo ("Realizar acciones matemáticamente similares a las que tuvieron éxito en el pasado"). La "función de objetivo" encapsula todos los objetivos sobre los que se impulsa al agente a actuar; en el caso de los agentes racionales, la función también encapsula las compensaciones aceptables entre el logro de objetivos en conflicto. (La terminología varía; por ejemplo, algunos agentes buscan maximizar o minimizar una " función de utilidad ", "función objetivo" o " función de pérdida ").

Los objetivos pueden definirse o inducirse explícitamente. Si la IA está programada para " aprendizaje por refuerzo ", tiene una " función de recompensa " que fomenta algunos tipos de comportamiento y castiga a otros. Alternativamente, un sistema evolutivo puede inducir objetivos mediante el uso de una " función de aptitud " para mutar y replicar preferentemente sistemas de IA de alta puntuación, similar a cómo los animales evolucionaron para desear de forma innata ciertos objetivos, como encontrar comida. Algunos sistemas de IA, como el vecino más cercano, en lugar de razonar por analogía, a estos sistemas generalmente no se les asignan objetivos, excepto en la medida en que los objetivos están implícitos en sus datos de entrenamiento. Dichos sistemas aún pueden ser comparados si el sistema sin objetivos se enmarca como un sistema cuyo "objetivo" es lograr su limitada tarea de clasificación.

Los sistemas que tradicionalmente no se consideran agentes, como los sistemas de representación del conocimiento, a veces se subsumen en el paradigma enmarcándolos como agentes que tienen el objetivo de (por ejemplo) responder preguntas con la mayor precisión posible; el concepto de "acción" se amplía aquí para abarcar el "acto" de dar una respuesta a una pregunta. Como una extensión adicional, los sistemas impulsados por mimetismo se pueden enmarcar como agentes que están optimizando una "función objetivo" en función de qué tan cerca logra la IA imitar el comportamiento deseado. En las redes generativas de confrontación de la década de 2010, un componente "codificador" / "generador" intenta imitar e improvisar la composición del texto humano. El generador está intentando maximizar una función encapsulando qué tan bien puede engañar a un componente antagonista "predictor" / "discriminador".

Si bien los sistemas GOFAI a menudo aceptan una función de objetivo explícita, el paradigma también se puede aplicar a las redes neuronales y a la computación evolutiva . El aprendizaje por refuerzo puede generar agentes inteligentes que parecen actuar de maneras destinadas a maximizar una "función de recompensa". A veces, en lugar de configurar la función de recompensa para que sea directamente igual a la función de evaluación de referencia deseada, los programadores de aprendizaje automático utilizarán la configuración de recompensas para otorgar inicialmente recompensas a la máquina por el progreso incremental en el aprendizaje. Yann LeCun declaró en 2018 que "la mayoría de los algoritmos de aprendizaje que la gente ha ideado consisten esencialmente en minimizar alguna función objetiva". El ajedrez AlphaZero tenía una función objetiva simple; cada victoria cuenta como +1 punto y cada derrota cuenta como -1 punto. Una función objetiva para un automóvil autónomo tendría que ser más complicada. La computación evolutiva puede desarrollar agentes inteligentes que parecen actuar de maneras destinadas a maximizar una "función de aptitud" que influye en cuántos descendientes se le permite dejar a cada agente.

El teórico y incomputable Aixi diseño es un agente máximamente inteligente en este paradigma; sin embargo, en el mundo real, la IA está limitada por tiempo finito y recursos de hardware, y los científicos compiten para producir algoritmos que pueden lograr puntajes progresivamente más altos en pruebas de referencia con hardware del mundo real.

Clases de agentes inteligentes

Clasificación de Russel y Norvig

Russell y Norvig (2003) agrupan a los agentes en cinco clases según su grado de inteligencia y capacidad percibidas:

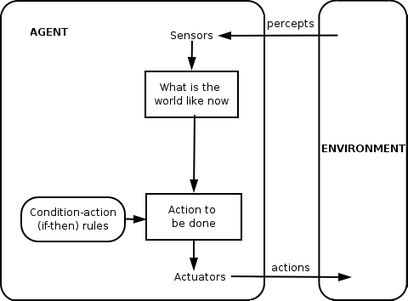

Agentes reflejos simples

Los agentes reflejos simples actúan sólo sobre la base de la percepción actual, ignorando el resto de la historia de la percepción. La función del agente se basa en la regla condición-acción : "si condición, entonces acción".

Esta función de agente solo tiene éxito cuando el entorno es completamente observable. Algunos agentes reflejos también pueden contener información sobre su estado actual, lo que les permite ignorar las condiciones cuyos actuadores ya están activados.

Los bucles infinitos son a menudo inevitables para los agentes reflejos simples que operan en entornos parcialmente observables. Nota: Si el agente puede aleatorizar sus acciones, es posible que se escape de infinitos bucles.

Agentes reflejos basados en modelos

Un agente basado en modelos puede manejar entornos parcialmente observables. Su estado actual se almacena dentro del agente manteniendo algún tipo de estructura que describe la parte del mundo que no se puede ver. Este conocimiento sobre "cómo funciona el mundo" se denomina modelo del mundo, de ahí el nombre de "agente basado en modelos".

Un agente reflejo basado en modelos debe mantener algún tipo de modelo interno que dependa del historial de percepción y, por lo tanto, refleje al menos algunos de los aspectos no observados del estado actual. El historial de percepción y el impacto de la acción en el medio ambiente se pueden determinar utilizando el modelo interno. Luego elige una acción de la misma manera que el agente reflejo.

Un agente también puede utilizar modelos para describir y predecir los comportamientos de otros agentes en el entorno.

Agentes basados en objetivos

Los agentes basados en objetivos amplían aún más las capacidades de los agentes basados en modelos mediante el uso de información de "objetivos". La información de la meta describe situaciones que son deseables. Esto proporciona al agente una forma de elegir entre múltiples posibilidades, seleccionando la que alcanza un estado objetivo. La búsqueda y la planificación son los subcampos de la inteligencia artificial dedicados a encontrar secuencias de acción que logren los objetivos del agente.

Agentes basados en servicios públicos

Los agentes basados en objetivos solo distinguen entre estados objetivo y estados no objetivo. También es posible definir una medida de cuán deseable es un estado en particular. Esta medida se puede obtener mediante el uso de una función de utilidad que mapea un estado con una medida de la utilidad del estado. Una medida de desempeño más general debería permitir una comparación de diferentes estados del mundo según cuán bien satisficieron los objetivos del agente. El término utilidad se puede utilizar para describir cuán "feliz" es el agente.

Un agente racional basado en la utilidad elige la acción que maximiza la utilidad esperada de los resultados de la acción, es decir, lo que el agente espera obtener, en promedio, dadas las probabilidades y utilidades de cada resultado. Un agente basado en la utilidad tiene que modelar y realizar un seguimiento de su entorno, tareas que han implicado una gran cantidad de investigación sobre percepción, representación, razonamiento y aprendizaje.

Agentes de aprendizaje

El aprendizaje tiene la ventaja de que permite a los agentes operar inicialmente en entornos desconocidos y volverse más competentes de lo que su conocimiento inicial por sí solo podría permitir. La distinción más importante es entre el "elemento de aprendizaje", que es responsable de realizar mejoras, y el "elemento de desempeño", que es responsable de seleccionar las acciones externas.

El elemento de aprendizaje utiliza la retroalimentación del "crítico" sobre cómo lo está haciendo el agente y determina cómo el elemento de desempeño, o "actor", debe modificarse para mejorar en el futuro. El elemento de desempeño es lo que antes hemos considerado el agente completo: toma percepciones y decide acciones.

El último componente del agente de aprendizaje es el "generador de problemas". Se encarga de sugerir acciones que conducirán a experiencias nuevas e informativas.

Clasificación de Weiss

Weiss (2013) define cuatro clases de agentes:

- Agentes basados en la lógica: en los que la decisión sobre qué acción realizar se realiza mediante deducción lógica;

- Agentes reactivos: en los que la toma de decisiones se implementa en alguna forma de mapeo directo de la situación a la acción;

- Agentes de creencias, deseos e intenciones, en los que la toma de decisiones depende de la manipulación de estructuras de datos que representan las creencias, los deseos y las intenciones del agente; y finalmente,

- Arquitecturas en capas: en las que la toma de decisiones se realiza a través de varias capas de software, cada una de las cuales razona más o menos explícitamente sobre el entorno en diferentes niveles de abstracción.

Jerarquías de agentes

Para realizar activamente sus funciones , los Agentes Inteligentes hoy en día normalmente se agrupan en una estructura jerárquica que contiene muchos "subagrupantes". Subagrupantes inteligentes procesan y realizan funciones de nivel inferior. Tomados en conjunto, el agente inteligente y los subagrupantes crean un sistema completo que puede lograr tareas u objetivos difíciles con comportamientos y respuestas que muestran una forma de inteligencia.

Generalmente, un agente puede construirse separando el cuerpo en sensores y actuadores, y de modo que opere con un sistema de percepción complejo que toma la descripción del mundo como entrada para un controlador y envía comandos al actuador. Sin embargo, a menudo es necesaria una jerarquía de capas de controlador para equilibrar la reacción inmediata deseada para las tareas de bajo nivel y el razonamiento lento sobre objetivos complejos de alto nivel.

Función de agente

Un programa de agente simple se puede definir matemáticamente como una función f (llamada "función de agente") que mapea cada secuencia de percepciones posible a una posible acción que el agente puede realizar o a un coeficiente, elemento de retroalimentación, función o constante que afecta acciones eventuales:

La función del agente es un concepto abstracto, ya que podría incorporar varios principios de toma de decisiones como el cálculo de la utilidad de las opciones individuales, la deducción sobre las reglas lógicas, la lógica difusa , etc.

El agente del programa , en cambio, asigna cada percepción posible a una acción.

Usamos el término percepción para referirnos a las entradas de percepción del agente en un instante dado. En las siguientes figuras, un agente es cualquier cosa que pueda verse como que percibe su entorno a través de sensores y actúa sobre ese entorno a través de actuadores.

Aplicaciones

Los agentes inteligentes se aplican como asistentes en línea automatizados , donde funcionan para percibir las necesidades de los clientes con el fin de realizar un servicio al cliente individualizado . Dicho agente puede consistir básicamente en un sistema de diálogo , un avatar , así como un sistema experto para proporcionar experiencia específica al usuario. También se pueden utilizar para optimizar la coordinación de grupos humanos en línea. Hallerbach y col. discutió la aplicación de enfoques basados en agentes para el desarrollo y validación de sistemas de conducción automatizados a través de un gemelo digital del vehículo bajo prueba y la simulación de tráfico microscópico basado en agentes independientes. Waymo ha creado un entorno de simulación de múltiples agentes, Carcraft, para probar algoritmos de vehículos autónomos . Simula las interacciones del tráfico entre conductores humanos, peatones y vehículos automatizados. El comportamiento de las personas es imitado por agentes artificiales basados en datos del comportamiento humano real. La idea básica de utilizar modelos basados en agentes para comprender los vehículos autónomos se discutió ya en 2003.

Definiciones y usos alternativos

"Agente inteligente" también se utiliza a menudo como un término de marketing vago, a veces sinónimo de " asistente personal virtual ". Algunas definiciones del siglo XX caracterizan a un agente como un programa que ayuda a un usuario o que actúa en nombre de un usuario. Estos ejemplos se conocen como agentes de software y, a veces, un "agente de software inteligente" (es decir, un agente de software con inteligencia) se denomina "agente inteligente".

Según Nikola Kasabov, los sistemas de IA deben presentar las siguientes características:

- Acomodar nuevas reglas de resolución de problemas de forma incremental

- Adáptese en línea y en tiempo real

- Son capaces de analizarse a sí mismos en términos de comportamiento, error y éxito.

- Aprender y mejorar a través de la interacción con el medio ambiente ( encarnación ).

- Aprenda rápidamente de grandes cantidades de datos

- Disponer de capacidades de recuperación y almacenamiento de ejemplares basadas en memoria

- Tener parámetros para representar la memoria a corto y largo plazo, la edad, el olvido, etc.

Ver también

- Agente de software

- Arquitecturas cognitivas

- Radio cognitiva : un campo práctico para la implementación

- Cibernética , Informática

- Agente de minería de datos

- Agente encarnado

- Búsqueda federada : la capacidad de los agentes para buscar fuentes de datos heterogéneas utilizando un solo vocabulario.

- Agentes difusos : IA implementado con lógica difusa adaptativa

- Lenguaje de programación de GOAL agent

- Inteligencia

- Sistema inteligente

- Agentes inteligentes JACK

- Sistema multi-agente y el sistema de agentes múltiples - varios agentes interactivos

- Clasificación PEAS del entorno de un agente

- Aprendizaje reforzado

- Web semántica : hacer que los datos en la Web estén disponibles para el procesamiento automatizado por parte de los agentes.

- Realidad simulada

- Simulación social

- Era de agentes inteligentes

Notas

Referencias en línea

otras referencias

- Domingos, Pedro (22 de septiembre de 2015). El algoritmo maestro: cómo la búsqueda de la máquina de aprendizaje definitiva reconstruirá nuestro mundo . Libros básicos . ISBN 978-0465065707.

- Russell, Stuart J .; Norvig, Peter (2003). Inteligencia artificial: un enfoque moderno (2ª ed.). Upper Saddle River, Nueva Jersey: Prentice Hall. Capítulo 2. ISBN 0-13-790395-2.

- Kasabov, N. (1998). "Introducción: sistemas adaptativos inteligentes híbridos". Revista Internacional de Sistemas Inteligentes . 13 (6): 453–454. doi : 10.1002 / (SICI) 1098-111X (199806) 13: 6 <453 :: AID-INT1> 3.0.CO; 2-K .

- Weiss, G. (2013). Sistemas multiagente (2ª ed.). Cambridge, MA: MIT Press. ISBN 978-0-262-01889-0.