Riesgo catastrófico global - Global catastrophic risk

Un riesgo catastrófico global es un evento futuro hipotético que podría dañar el bienestar humano a escala global, incluso poniendo en peligro o destruyendo la civilización moderna . Un evento que podría causar la extinción humana o reducir de manera permanente y drástica el potencial de la humanidad se conoce como riesgo existencial .

Los posibles riesgos catastróficos globales incluyen riesgos antropogénicos , causados por humanos (tecnología, gobernanza, cambio climático) y riesgos no antropogénicos o naturales . Los riesgos tecnológicos incluyen la creación de inteligencia artificial destructiva , biotecnología o nanotecnología . Una gobernanza global insuficiente o maligna crea riesgos en el ámbito social y político, como una guerra global , incluido el holocausto nuclear , el bioterrorismo que utiliza organismos genéticamente modificados , el ciberterrorismo que destruye la infraestructura crítica como la red eléctrica ; o el fracaso en el manejo de una pandemia natural . Los problemas y riesgos en el dominio de la gobernanza del sistema terrestre incluyen el calentamiento global , la degradación ambiental , incluida la extinción de especies, el hambre como resultado de una distribución no equitativa de los recursos, la superpoblación humana , las malas cosechas y la agricultura no sostenible .

Ejemplos de riesgos no antropogénicos son un evento de impacto de asteroide , una erupción supervolcánica , una explosión letal de rayos gamma , una tormenta geomagnética que destruye equipos electrónicos, el cambio climático natural a largo plazo , la vida extraterrestre hostil o el predecible Sol transformándose en una gigante roja. estrella que envuelve la Tierra.

Durante las últimas dos décadas, se han establecido varias organizaciones académicas y sin fines de lucro para investigar los riesgos catastróficos y existenciales globales y formular posibles medidas de mitigación.

Definición y clasificación

Definición de riesgos catastróficos globales

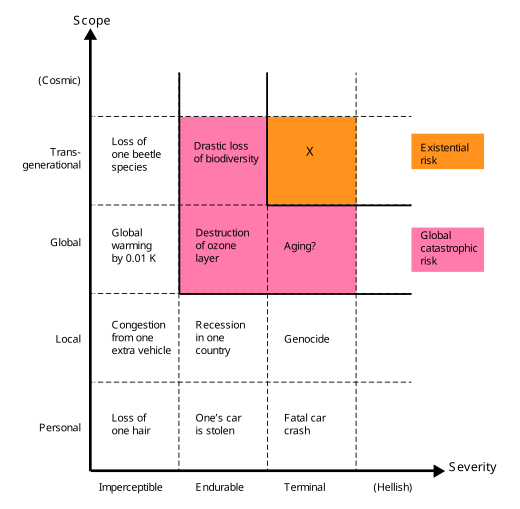

El término riesgo catastrófico global "carece de una definición precisa" y, en general, se refiere (vagamente) a un riesgo que podría infligir "daños graves al bienestar humano a escala mundial".

La humanidad ha sufrido grandes catástrofes antes. Algunos de estos han causado daños graves, pero solo tenían un alcance local; por ejemplo, la peste negra puede haber provocado la muerte de un tercio de la población europea, el 10% de la población mundial en ese momento. Algunos eran globales, pero no tan graves, por ejemplo, la pandemia de influenza de 1918 mató a aproximadamente entre el 3 y el 6% de la población mundial. La mayoría de los riesgos catastróficos globales no serían tan intensos como para matar la mayor parte de la vida en la tierra, pero incluso si uno lo hiciera, el ecosistema y la humanidad eventualmente se recuperarían (en contraste con los riesgos existenciales ).

De manera similar, en Catástrofe: Riesgo y respuesta , Richard Posner destaca y agrupa eventos que provocan un "derrocamiento o ruina total" a escala global, en lugar de "local o regional". Posner destaca estos eventos como dignos de atención especial por motivos de costo-beneficio porque podrían poner en peligro directa o indirectamente la supervivencia de la raza humana en su conjunto.

Definición de riesgos existenciales

Los riesgos existenciales se definen como "riesgos que amenazan con la destrucción del potencial a largo plazo de la humanidad". La instanciación de un riesgo existencial (una catástrofe existencial ) causaría la extinción humana total o encerraría irreversiblemente en un estado de cosas drásticamente inferior. Los riesgos existenciales son una subclase de riesgos catastróficos globales, donde el daño no solo es global , sino también terminal y permanente (impidiendo la recuperación y por lo tanto impactando tanto a la generación actual como a todas las generaciones posteriores).

Riesgos de no extinción

Mientras que la extinción es la forma más obvia en la que la humanidad es el potencial a largo plazo podría ser destruida, hay otros, entre ellos irrecuperable colapso y irrecuperable distopía . Un desastre lo suficientemente grave como para causar el colapso permanente e irreversible de la civilización humana constituiría una catástrofe existencial, incluso si no llegara a la extinción. De manera similar, si la humanidad cayera bajo un régimen totalitario y no hubiera posibilidad de recuperación, como lo imaginó George Orwell en su novela Mil novecientos ochenta y cuatro de 1949 , ese futuro distópico también sería una catástrofe existencial. Bryan Caplan escribe que "quizás una eternidad de totalitarismo sería peor que la extinción". Un escenario distópico comparte las características clave de la extinción y el colapso irrecuperable de la civilización: antes de la catástrofe, la humanidad se enfrentaba a una amplia gama de futuros brillantes para elegir; después de la catástrofe, la humanidad queda atrapada para siempre en un estado terrible.

Probabilidad

Natural versus antropogénico

Los expertos generalmente están de acuerdo en que los riesgos existenciales antropogénicos son (mucho) más probables que los riesgos naturales. Una diferencia clave entre estos tipos de riesgo es que la evidencia empírica puede colocar un límite superior en el nivel de riesgo natural. La humanidad ha existido durante al menos 200.000 años, durante los cuales ha estado sujeta a un nivel aproximadamente constante de riesgo natural. Si el riesgo natural fuera alto, sería muy poco probable que la humanidad hubiera sobrevivido tanto tiempo. Sobre la base de una formalización de este argumento, los investigadores han concluido que podemos estar seguros de que el riesgo natural es inferior a 1 en 14.000 (y probablemente "menos de uno en 87.000") por año.

Otro método empírico para estudiar la probabilidad de ciertos riesgos naturales es investigar el registro geológico. Por ejemplo, un evento de impacto de cometa o asteroide en escala suficiente para causar un invierno de impacto que causaría la extinción humana antes del año 2100 se ha estimado en uno en un millón. Además, las grandes erupciones de supervolcanes pueden provocar un invierno volcánico que podría poner en peligro la supervivencia de la humanidad. El registro geológico sugiere que se estima que las erupciones supervolcánicas ocurren en promedio cada 50.000 años, aunque la mayoría de estas erupciones no alcanzarían la escala requerida para causar la extinción humana. Es famoso que el supervolcán Monte Toba casi haya acabado con la humanidad en el momento de su última erupción (aunque esto es polémico).

Dado que el riesgo antropogénico es un fenómeno relativamente reciente, el historial de supervivencia de la humanidad no puede ofrecer garantías similares. La humanidad solo ha sobrevivido 75 años desde la creación de las armas nucleares, y para las tecnologías futuras no existe ningún historial. Esto ha llevado a pensadores como Carl Sagan a concluir que la humanidad se encuentra actualmente en una 'época de peligros', un período singularmente peligroso en la historia de la humanidad, donde está sujeta a niveles de riesgo sin precedentes, comenzando desde que comenzamos a plantear riesgos para nosotros mismos a través de nuestras acciones.

Estimaciones de riesgo

Dadas las limitaciones de la observación y el modelado ordinarios, con frecuencia se utiliza la elicitación de expertos para obtener estimaciones de probabilidad. En 2008, una encuesta informal de expertos en una conferencia organizada por el Future of Humanity Institute estimó un 19% de riesgo de extinción humana para el año 2100, aunque dadas las limitaciones de la encuesta, estos resultados deben tomarse "con un grano de sal".

Riesgo Probabilidad estimada

de extinción humana

antes de 2100Probabilidad general 19% Armas de nanotecnología molecular 5% IA superinteligente 5% Todas las guerras (incluidas las guerras civiles) 4% Pandemia diseñada 2% Guerra nuclear 1% Accidente de nanotecnología 0,5% Pandemia natural 0,05% Terrorismo nuclear 0,03% Fuente de la tabla: Future of Humanity Institute , 2008.

Ha habido una serie de otras estimaciones de riesgo existencial, riesgo de extinción o un colapso global de la civilización:

- En 1996, John Leslie estimó un riesgo del 30% durante los próximos cinco siglos (equivalente a alrededor del 9% por siglo, en promedio).

- En 2002, Nick Bostrom dio la siguiente estimación del riesgo existencial a largo plazo: "Mi opinión subjetiva es que establecer esta probabilidad por debajo del 25% sería erróneo, y la mejor estimación puede ser considerablemente más alta".

- En 2003, Martin Rees estimó un 50% de posibilidades de colapso de la civilización en el siglo XXI.

- El informe anual de 2016 de la Global Challenges Foundation estima una probabilidad anual de extinción humana de al menos un 0,05% anual.

- Una encuesta de 2016 de expertos en IA encontró una estimación media del 5% de que la IA a nivel humano causaría un resultado que era "extremadamente malo (por ejemplo, la extinción humana)".

- En 2020, Toby Ord estima el riesgo existencial en el próximo siglo en '1 en 6' en su libro The Precipice: Existential Risk and the Future of Humanity .

- Los usuarios de Metaculus actualmente estiman un 3% de probabilidad de que la humanidad se extinga antes de 2100.

Desafíos metodológicos

La investigación sobre la naturaleza y la mitigación de los riesgos catastróficos globales y los riesgos existenciales está sujeta a un conjunto único de desafíos y, en consecuencia, no se sujeta fácilmente a los estándares habituales de rigor científico. Por ejemplo, no es factible ni ético estudiar estos riesgos de forma experimental. Carl Sagan expresó esto con respecto a la guerra nuclear: “Comprender las consecuencias a largo plazo de la guerra nuclear no es un problema susceptible de verificación experimental”. Además, muchos riesgos catastróficos cambian rápidamente a medida que avanza la tecnología y cambian las condiciones de fondo (como las relaciones internacionales). Otro desafío es la dificultad general de predecir con precisión el futuro en escalas de tiempo prolongadas, especialmente para los riesgos antropogénicos que dependen de complejos sistemas humanos políticos, económicos y sociales. Además de los riesgos conocidos y tangibles, pueden ocurrir eventos imprevisibles de extinción del cisne negro , lo que presenta un problema metodológico adicional.

Falta de precedente histórico

La humanidad nunca ha sufrido una catástrofe existencial y si ocurriera una, necesariamente no tendría precedentes. Por lo tanto, los riesgos existenciales plantean desafíos únicos para la predicción, incluso más que otros eventos a largo plazo, debido a los efectos de selección de la observación . A diferencia de la mayoría de los eventos, el hecho de que un evento de extinción completo no ocurra en el pasado no es evidencia en contra de su probabilidad en el futuro, porque todos los mundos que han experimentado tal evento de extinción no tienen observadores, por lo que, independientemente de su frecuencia, ninguna civilización observa. riesgos existenciales en su historia. Estos problemas antrópicos pueden evitarse en parte al observar la evidencia que no tiene tales efectos de selección, como los cráteres de impacto de asteroides en la Luna, o al evaluar directamente el impacto probable de la nueva tecnología.

Para comprender la dinámica de un colapso global de civilizaciones sin precedentes e irrecuperable (un tipo de riesgo existencial), puede ser instructivo estudiar los diversos colapsos de civilizaciones locales que han ocurrido a lo largo de la historia de la humanidad. Por ejemplo, civilizaciones como el Imperio Romano han terminado en una pérdida de gobierno centralizado y una gran pérdida de infraestructura y tecnología avanzada en toda la civilización. Sin embargo, estos ejemplos demuestran que las sociedades parecen ser bastante resistentes a las catástrofes; por ejemplo, la Europa medieval sobrevivió a la peste negra sin sufrir nada parecido al colapso de una civilización a pesar de perder entre el 25 y el 50 por ciento de su población.

Incentivos y coordinación

Hay razones económicas que pueden explicar por qué se dedica tan poco esfuerzo a la reducción del riesgo existencial. Es un bien público mundial , por lo que deberíamos esperar que los mercados lo subasten. Incluso si una nación grande invierte en medidas de mitigación de riesgos, esa nación disfrutará solo de una pequeña fracción del beneficio de hacerlo. Además, la reducción del riesgo existencial es un bien público global intergeneracional , ya que la mayoría de los beneficios de la reducción del riesgo existencial serían disfrutados por las generaciones futuras, y aunque estas personas del futuro, en teoría, tal vez estarían dispuestas a pagar sumas sustanciales por la reducción del riesgo existencial, no existe ningún mecanismo. porque tal transacción existe.

Sesgos cognitivos

Numerosos sesgos cognitivos pueden influir en el juicio de las personas sobre la importancia de los riesgos existenciales, incluida la insensibilidad del alcance , el descuento hiperbólico , la heurística de disponibilidad , la falacia de conjunción , la heurística del afecto y el efecto de exceso de confianza .

La insensibilidad al alcance influye en lo mala que la gente considera que es la extinción de la raza humana. Por ejemplo, cuando las personas están motivadas a donar dinero a causas altruistas, la cantidad que están dispuestas a dar no aumenta linealmente con la magnitud del problema: la gente está más o menos dispuesta a prevenir la muerte de 200.000 o 2.000 aves. De manera similar, las personas suelen estar más preocupadas por las amenazas a los individuos que a los grupos más grandes.

Importancia moral del riesgo existencial

En una de las primeras discusiones sobre la ética de la extinción humana, Derek Parfit ofrece el siguiente experimento mental:

Creo que si destruimos a la humanidad, como podemos ahora, este resultado será mucho peor de lo que la mayoría de la gente piensa. Compare tres resultados:

(1) Paz.

(2) Una guerra nuclear que acaba con el 99% de la población mundial existente.

(3) Una guerra nuclear que mata al 100%.

(2) sería peor que (1) y (3) sería peor que (2). ¿Cuál es la mayor de estas dos diferencias? La mayoría de la gente cree que la mayor diferencia está entre (1) y (2). Creo que la diferencia entre (2) y (3) es mucho mayor.

- Derek Parfit

La escala de lo que se pierde en una catástrofe existencial está determinada por el potencial a largo plazo de la humanidad: lo que la humanidad podría esperar lograr si sobreviviera. Desde una perspectiva utilitaria , el valor de proteger a la humanidad es el producto de su duración (cuánto tiempo sobrevive la humanidad), su tamaño (cuántos humanos hay a lo largo del tiempo) y su calidad (en promedio, qué tan buena es la vida para las personas futuras). . En promedio, las especies sobreviven alrededor de un millón de años antes de extinguirse. Parfit señala que la Tierra seguirá siendo habitable durante unos mil millones de años. Y estos podrían ser límites más bajos en nuestro potencial: si la humanidad es capaz de expandirse más allá de la Tierra , podría aumentar enormemente la población humana y sobrevivir durante billones de años. El tamaño del potencial perdido que se perdería si la humanidad se extinguiera, es muy grande. Por lo tanto, reducir el riesgo existencial incluso en una pequeña cantidad tendría un valor moral muy significativo.

Algunos economistas y filósofos han defendido puntos de vista, incluido el descuento exponencial y los puntos de vista que afectan a las personas sobre la ética de la población , en los que las personas del futuro no importan (o importan mucho menos), moralmente hablando. Si bien estos puntos de vista son controvertidos, incluso ellos estarían de acuerdo en que una catástrofe existencial estaría entre las peores cosas imaginables. Cortaría la vida de ocho mil millones de personas que existen en la actualidad, destruyendo todo lo que hace que sus vidas sean valiosas y, muy probablemente, sometiendo a muchas de ellas a un sufrimiento profundo. Entonces, incluso dejando de lado el valor de las generaciones futuras, puede haber fuertes razones para reducir el riesgo existencial, basadas en la preocupación por las personas que existen en el presente.

Más allá del utilitarismo, otras perspectivas morales apoyan la importancia de reducir el riesgo existencial. Una catástrofe existencial destruiría algo más que la humanidad: destruiría todos los artefactos culturales, idiomas y tradiciones, y muchas de las cosas que valoramos. Por lo tanto, los puntos de vista morales sobre los que tenemos el deber de proteger y apreciar las cosas de valor verían esto como una gran pérdida que debería evitarse. También se pueden considerar razones basadas en deberes para con las generaciones pasadas. Por ejemplo, Edmund Burke escribe sobre una "asociación ... entre los que están vivos, los que están muertos y los que van a nacer". Si uno se toma en serio la deuda que la humanidad tiene con las generaciones pasadas, Ord argumenta que la mejor manera de pagarla podría ser "pagarla" y asegurarse de que la herencia de la humanidad se transmita a las generaciones futuras.

Hay varios economistas que han discutido la importancia de los riesgos catastróficos globales. Por ejemplo, Martin Weitzman sostiene que la mayor parte del daño económico esperado por el cambio climático puede provenir de la pequeña posibilidad de que el calentamiento supere en gran medida las expectativas de rango medio, lo que resultará en daños catastróficos. Richard Posner ha argumentado que la humanidad está haciendo muy poco, en general, sobre los riesgos pequeños y difíciles de estimar de catástrofes a gran escala.

Posibles fuentes de riesgo

Algunas fuentes de riesgo catastrófico son antropogénicas (creadas por el hombre), como el calentamiento global, la degradación ambiental, las pandemias diseñadas y la guerra nuclear. Por otro lado, algunos riesgos no son antropogénicos o naturales , como los impactos de meteoritos o supervolcanes.

Antropogénico

Muchos expertos, incluidos los del Future of Humanity Institute de la Universidad de Oxford y el Centro para el estudio del riesgo existencial de la Universidad de Cambridge, dan prioridad a los riesgos antropogénicos sobre los naturales debido a su probabilidad estimada mucho mayor. Están especialmente preocupados y, en consecuencia, se centran en los riesgos que plantean las tecnologías avanzadas, como la inteligencia artificial y la biotecnología.

Inteligencia artificial

Se ha sugerido que si los sistemas de IA se vuelven superinteligentes rápidamente , pueden tomar acciones imprevistas o superar a la humanidad. Según el filósofo Nick Bostrom , es posible que la primera superinteligencia que surja sea capaz de producir casi cualquier resultado posible que valore, así como frustrar prácticamente cualquier intento de evitar que logre sus objetivos. Por lo tanto, incluso una superinteligencia indiferente a la humanidad podría ser peligrosa si percibiera a los humanos como un obstáculo para objetivos no relacionados. En el libro Superintelligence de Bostrom , define esto como el problema de control . El físico Stephen Hawking , el fundador de Microsoft , Bill Gates , y el fundador de SpaceX , Elon Musk, se han hecho eco de estas preocupaciones, y Hawking ha teorizado que tal IA podría "significar el fin de la raza humana".

En 2009, la Asociación para el Avance de la Inteligencia Artificial (AAAI) organizó una conferencia para discutir si las computadoras y los robots podrían adquirir algún tipo de autonomía , y en qué medida estas habilidades podrían representar una amenaza o peligro. Señalaron que algunos robots han adquirido varias formas de semiautonomía, incluida la posibilidad de encontrar fuentes de energía por sí mismos y la posibilidad de elegir objetivos de forma independiente para atacar con armas. También señalaron que algunos virus informáticos pueden evadir la eliminación y han logrado "inteligencia de cucaracha". Señalaron que la autoconciencia como se describe en la ciencia ficción es probablemente poco probable, pero existen otros peligros y trampas potenciales. Varias fuentes de medios y grupos científicos han notado tendencias separadas en diferentes áreas que, juntas, podrían resultar en mayores funcionalidades robóticas y autonomía, y que plantean algunas preocupaciones inherentes.

Una encuesta de expertos en inteligencia artificial estimó que la probabilidad de que el aprendizaje automático a nivel humano tenga un efecto a largo plazo "extremadamente malo (por ejemplo, la extinción humana)" en la humanidad es del 5%. Una encuesta de 2008 del Future of Humanity Institute estimó una probabilidad del 5% de extinción por superinteligencia para 2100. Eliezer Yudkowsky cree que los riesgos de la inteligencia artificial son más difíciles de predecir que cualquier otro riesgo conocido debido al sesgo del antropomorfismo . Dado que las personas basan sus juicios sobre la inteligencia artificial en su propia experiencia, afirma que subestiman el poder potencial de la IA.

Biotecnología

La biotecnología puede representar un riesgo catastrófico global en forma de organismos modificados por bioingeniería ( virus , bacterias , hongos , plantas o animales ). En muchos casos, el organismo será un patógeno de humanos, ganado , cultivos u otros organismos de los que dependemos (por ejemplo, polinizadores o bacterias intestinales ). Sin embargo, cualquier organismo capaz de alterar catastróficamente las funciones de los ecosistemas , por ejemplo , malas hierbas altamente competitivas que superan a los cultivos esenciales, presenta un riesgo biotecnológico.

Una catástrofe biotecnológica puede ser causada por la liberación accidental de un organismo modificado genéticamente de ambientes controlados, por la liberación planificada de dicho organismo que luego resulta tener interacciones catastróficas e imprevistas con ecosistemas naturales o agroecosistemas esenciales, o por el uso intencional de agentes biológicos. en ataques de guerra biológica o bioterrorismo . Los patógenos pueden modificarse genéticamente de forma intencionada o no intencionada para cambiar la virulencia y otras características. Por ejemplo, un grupo de investigadores australianos cambió involuntariamente las características del virus de la viruela del ratón mientras intentaba desarrollar un virus para esterilizar roedores. El virus modificado se volvió altamente letal incluso en ratones vacunados y con resistencia natural. Es probable que los medios tecnológicos para modificar genéticamente las características de los virus estén más disponibles en el futuro si no se regulan adecuadamente.

Históricamente, las aplicaciones terroristas de la biotecnología han sido poco frecuentes. No se resuelve hasta qué punto esto se debe a una falta de capacidades o motivación. Sin embargo, dado el desarrollo actual, se espera un mayor riesgo de nuevos patógenos diseñados en el futuro. Se ha observado un crecimiento exponencial en el sector de la biotecnología , y Noun y Chyba predicen que esto conducirá a importantes aumentos en las capacidades biotecnológicas en las próximas décadas. Argumentan que los riesgos de la guerra biológica y el bioterrorismo son distintos de las amenazas nucleares y químicas porque los patógenos biológicos son más fáciles de producir en masa y su producción es difícil de controlar (especialmente porque las capacidades tecnológicas están disponibles incluso para usuarios individuales). En 2008, una encuesta del Future of Humanity Institute estimó una probabilidad del 2% de extinción por pandemias diseñadas para el 2100.

Noun y Chyba proponen tres categorías de medidas para reducir los riesgos de la biotecnología y las pandemias naturales: regulación o prevención de investigaciones potencialmente peligrosas, mejor reconocimiento de los brotes y desarrollo de instalaciones para mitigar los brotes de enfermedades (por ejemplo, mejores vacunas y / o más ampliamente distribuidas).

Ataque cibernetico

Los ciberataques tienen el potencial de destruir todo, desde datos personales hasta redes eléctricas. Christine Peterson , cofundadora y ex presidenta del Foresight Institute , cree que un ciberataque a las redes eléctricas tiene el potencial de ser un riesgo catastrófico. Señala que se ha hecho poco para mitigar esos riesgos y que la mitigación podría llevar varias décadas de reajuste.

Desastre ambiental

Un desastre ambiental o ecológico, como la pérdida de cosechas en el mundo y el colapso de los servicios de los ecosistemas , podría ser inducido por las tendencias actuales de superpoblación , desarrollo económico y agricultura no sostenible . La mayoría de los escenarios ambientales involucran uno o más de los siguientes: evento de extinción del Holoceno , escasez de agua que podría llevar a que aproximadamente la mitad de la población de la Tierra se quede sin agua potable, disminución de polinizadores , sobrepesca , deforestación masiva , desertificación , cambio climático o contaminación masiva del agua. episodios. Detectado a principios del siglo XXI, una amenaza en esta dirección es el desorden de colapso de colonias , un fenómeno que podría presagiar la inminente extinción de la abeja occidental . Dado que la abeja juega un papel vital en la polinización, su extinción interrumpiría gravemente la cadena alimentaria .

Un informe de octubre de 2017 publicado en The Lancet declaró que el aire, el agua , los suelos y los lugares de trabajo tóxicos fueron responsables colectivamente de nueve millones de muertes en todo el mundo en 2015, particularmente por la contaminación del aire, que estaba relacionada con las muertes al aumentar la susceptibilidad a enfermedades no infecciosas, como enfermedad cardíaca , accidente cerebrovascular y cáncer de pulmón . El informe advirtió que la crisis de contaminación estaba excediendo "el límite de la cantidad de contaminación que la Tierra puede transportar" y "amenaza la supervivencia continua de las sociedades humanas".

Un análisis de mayo de 2020 publicado en Scientific Reports encontró que si la deforestación y el consumo de recursos continúan al ritmo actual, podrían culminar en un "colapso catastrófico de la población humana" y posiblemente "un colapso irreversible de nuestra civilización" en las próximas décadas. El estudio dice que la humanidad debería pasar de una civilización dominada por la economía a una "sociedad cultural" que "privilegia el interés del ecosistema por encima del interés individual de sus componentes, pero eventualmente de acuerdo con el interés común general". Los autores también señalan que "si bien los eventos violentos, como la guerra global o los eventos naturales catastróficos, son una preocupación inmediata para todos, un consumo relativamente lento de los recursos planetarios puede no ser percibido con tanta fuerza como un peligro mortal para la civilización humana".

Accidente de tecnología experimental

Nick Bostrom sugirió que en la búsqueda del conocimiento, la humanidad podría crear inadvertidamente un dispositivo que podría destruir la Tierra y el Sistema Solar. Las investigaciones en física nuclear y de altas energías podrían crear condiciones inusuales con consecuencias catastróficas. Por ejemplo, a los científicos les preocupaba que la primera prueba nuclear pudiera encender la atmósfera. A otros les preocupaba que el RHIC o el Gran Colisionador de Hadrones pudieran iniciar un desastre global de reacción en cadena que involucre agujeros negros , extraños o estados de vacío falso . Estas preocupaciones particulares han sido cuestionadas, pero la preocupación general permanece.

La biotecnología podría conducir a la creación de una pandemia , la guerra química podría llevarse al extremo, la nanotecnología podría conducir a una sustancia viscosa gris en la que los robots autorreplicantes fuera de control consumen toda la materia viva en la tierra mientras construyen más de sí mismos, en ambos casos, ya sea deliberadamente o por accidente.

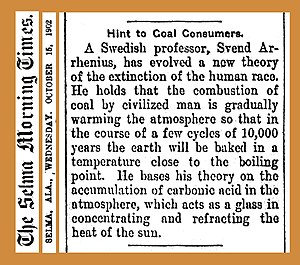

Calentamiento global

El calentamiento global se refiere al calentamiento causado por la tecnología humana desde el siglo XIX o antes. Las proyecciones del cambio climático futuro sugieren un mayor calentamiento global, aumento del nivel del mar y un aumento en la frecuencia y severidad de algunos eventos climáticos extremos y desastres relacionados con el clima. Los efectos del calentamiento global incluyen pérdida de biodiversidad , estrés en los sistemas de producción de alimentos existentes, mayor propagación de enfermedades infecciosas conocidas como la malaria y rápida mutación de microorganismos . En noviembre de 2017, una declaración de 15.364 científicos de 184 países indicó que los niveles crecientes de gases de efecto invernadero por el uso de combustibles fósiles, el crecimiento de la población humana, la deforestación y el uso excesivo de la tierra para la producción agrícola, en particular por la cría de rumiantes para el consumo de carne, son tendencias en formas que pronostican un aumento de la miseria humana en las próximas décadas.

Agotamiento de recursos minerales

El economista rumano estadounidense Nicholas Georgescu-Roegen , un progenitor de la economía y el fundador del paradigma de la economía ecológica , ha argumentado que la capacidad de carga de la Tierra, es decir, la capacidad de la Tierra para sostener las poblaciones humanas y los niveles de consumo, está destinada a disminuir en algún momento en el futuro. dado que la reserva finita de recursos minerales de la Tierra se está extrayendo y utilizando actualmente; y, en consecuencia, que la economía mundial en su conjunto se encamina hacia un colapso futuro inevitable, que conducirá a la desaparición de la propia civilización humana . El economista ecológico y teórico del estado estacionario Herman Daly , estudiante de Georgescu-Roegen, ha propuesto el mismo argumento al afirmar que "... todo lo que podemos hacer es evitar desperdiciar la capacidad limitada de la creación para sustentar la vida presente y futura [en Tierra]."

Desde que Georgescu-Roegen y Daly publicaron estos puntos de vista, varios académicos en el campo han estado discutiendo la imposibilidad existencial de distribuir el stock finito de recursos minerales de la tierra de manera uniforme entre un número desconocido de generaciones presentes y futuras. Es probable que este número de generaciones siga siendo desconocido para nosotros, ya que no hay forma, o sólo una pequeña forma, de saber de antemano si la humanidad se enfrentará finalmente a la extinción o cuándo . En efecto, cualquier asignación intertemporal concebible de la acción terminará inevitablemente con un declive económico universal en algún momento futuro.

Nanotecnología

Muchas tecnologías a nanoescala están en desarrollo o actualmente en uso. El único que parece plantear un riesgo catastrófico global significativo es la fabricación molecular , una técnica que permitiría construir estructuras complejas con precisión atómica. La fabricación molecular requiere avances significativos en nanotecnología, pero una vez lograda, se podrían producir productos muy avanzados a bajos costos y en grandes cantidades en nanofábricas de proporciones de escritorio. Cuando las nanofábricas adquieren la capacidad de producir otras nanofábricas, la producción solo puede verse limitada por factores relativamente abundantes, como los materiales de entrada, la energía y el software.

La fabricación molecular podría utilizarse para producir de forma económica, entre muchos otros productos, armas duraderas y muy avanzadas. Al estar equipados con computadoras y motores compactos, estos podrían ser cada vez más autónomos y tener una amplia gama de capacidades.

Chris Phoenix y Treder clasifican los riesgos catastróficos que plantea la nanotecnología en tres categorías:

- A partir de potenciar el desarrollo de otras tecnologías como la IA y la biotecnología.

- Permitiendo la producción en masa de productos potencialmente peligrosos que provocan dinámicas de riesgo (como carreras de armamentos) dependiendo de cómo se utilicen.

- De procesos incontrolados que se auto-perpetúan con efectos destructivos.

Varios investigadores dicen que la mayor parte del riesgo de la nanotecnología proviene del potencial de conducir a guerras, carreras armamentistas y gobiernos globales destructivos. Se han sugerido varias razones por las que la disponibilidad de armamento nanotecnológico puede conducir con gran probabilidad a carreras de armamentos inestables (en comparación con, por ejemplo, carreras de armamentos nucleares):

- Un gran número de jugadores puede verse tentado a participar en la carrera, ya que el umbral para hacerlo es bajo;

- La capacidad de fabricar armas con fabricación molecular será barata y fácil de ocultar;

- Por lo tanto, la falta de conocimiento de las capacidades de las otras partes puede tentar a los jugadores a armarse por precaución o lanzar ataques preventivos ;

- La fabricación molecular puede reducir la dependencia del comercio internacional, un factor potencial de promoción de la paz;

- Las guerras de agresión pueden representar una amenaza económica menor para el agresor, ya que la fabricación es barata y es posible que no se necesiten humanos en el campo de batalla.

Dado que la autorregulación de todos los actores estatales y no estatales parece difícil de lograr, las medidas para mitigar los riesgos relacionados con la guerra se han propuesto principalmente en el ámbito de la cooperación internacional . La infraestructura internacional puede ampliarse dando más soberanía al nivel internacional. Esto podría ayudar a coordinar los esfuerzos para el control de armas. También se pueden diseñar instituciones internacionales dedicadas específicamente a la nanotecnología (quizás de manera análoga al Organismo Internacional de Energía Atómica OIEA ) o al control general de armas. También se pueden realizar conjuntamente avances tecnológicos diferenciales en tecnologías defensivas, una política que los jugadores deberían favorecer habitualmente. El Centro de Nanotecnología Responsable también sugiere algunas restricciones técnicas. Una mayor transparencia con respecto a las capacidades tecnológicas puede ser otro facilitador importante para el control de armamentos.

La sustancia pegajosa gris es otro escenario catastrófico, que fue propuesto por Eric Drexler en su libro Engines of Creation de 1986 y ha sido un tema en los principales medios de comunicación y ficción. Este escenario involucra pequeños robots autorreplicantes que consumen toda la biosfera usándola como fuente de energía y bloques de construcción. Hoy en día, sin embargo, los expertos en nanotecnología, incluido Drexler, desacreditan el escenario. Según Phoenix, una "supuesta sustancia viscosa gris sólo podría ser el producto de un proceso de ingeniería deliberado y difícil, no un accidente".

Guerra y destrucción masiva

Los escenarios que se han explorado con mayor frecuencia son la guerra nuclear y los dispositivos del fin del mundo . Lanzar por error un ataque nuclear en respuesta a una falsa alarma es un escenario posible; esto casi sucedió durante el incidente de falsa alarma nuclear soviética de 1983 . Aunque la probabilidad de una guerra nuclear por año es escasa, el profesor Martin Hellman la ha descrito como inevitable a largo plazo; a menos que la probabilidad se acerque a cero, inevitablemente llegará el día en que la suerte de la civilización se agote. Durante la Crisis de los Misiles en Cuba , el presidente estadounidense John F. Kennedy estimó las probabilidades de una guerra nuclear en "algún lugar entre uno de cada tres e incluso". Estados Unidos y Rusia tienen un arsenal combinado de 14,700 armas nucleares , y hay un total estimado de 15,700 armas nucleares en existencia en todo el mundo. Más allá de las armas nucleares, otras amenazas militares para la humanidad incluyen la guerra biológica (BW). Por el contrario, la guerra química , aunque puede crear múltiples catástrofes locales, es poco probable que cree una global.

La guerra nuclear podría producir un número sin precedentes de muertes humanas y destrucción del hábitat . La detonación de un gran número de armas nucleares tendría efectos inmediatos, a corto y largo plazo en el clima, provocando un clima frío y una reducción de la luz solar y la fotosíntesis que pueden generar trastornos importantes en las civilizaciones avanzadas. Sin embargo, mientras que la percepción popular a veces toma la guerra nuclear como "el fin del mundo", los expertos asignan una baja probabilidad a la extinción humana de una guerra nuclear. En 1982, Brian Martin calculó que un intercambio nuclear entre Estados Unidos y la Unión Soviética podría matar entre 400 y 450 millones directamente, principalmente en Estados Unidos, Europa y Rusia, y tal vez varios cientos de millones más a través de consecuencias posteriores en esas mismas áreas. En 2008, una encuesta realizada por el Instituto del Futuro de la Humanidad estimó una probabilidad del 4% de extinción por guerra para 2100, con un 1% de probabilidad de extinción por guerra nuclear.

Población mundial y crisis agrícola

El siglo XX vio un rápido aumento de la población humana debido a los avances médicos y los aumentos masivos de la productividad agrícola, como la Revolución Verde . Entre 1950 y 1984, cuando la Revolución Verde transformó la agricultura en todo el mundo, la producción mundial de cereales aumentó en un 250%. La Revolución Verde en la agricultura ayudó a la producción de alimentos a seguir el ritmo del crecimiento de la población mundial o, de hecho, permitió el crecimiento de la población. La energía para la Revolución Verde fue proporcionada por combustibles fósiles en forma de fertilizantes (gas natural), pesticidas (aceite) e irrigación alimentada con hidrocarburos . David Pimentel, profesor de ecología y agricultura en la Universidad de Cornell , y Mario Giampietro, investigador principal del Instituto Nacional de Investigación sobre Alimentación y Nutrición (INRAN), colocan en su estudio de 1994 Food, Land, Population and the US Economy la población estadounidense máxima para una economía sostenible en 200 millones. Para lograr una economía sostenible y evitar un desastre, Estados Unidos debe reducir su población en al menos un tercio, y la población mundial tendrá que reducirse en dos tercios, dice el estudio.

Los autores de este estudio creen que la crisis agrícola mencionada comenzará a tener un efecto en el mundo después de 2020 y se volverá crítica después de 2050. El geólogo Dale Allen Pfeiffer afirma que las próximas décadas podrían ver un aumento vertiginoso de los precios de los alimentos sin alivio y una hambruna masiva a nivel mundial. nivel como nunca antes experimentado.

Dado que los suministros de petróleo y gas natural son esenciales para las técnicas agrícolas modernas, una caída en los suministros mundiales de petróleo (consulte el pico del petróleo para conocer las preocupaciones mundiales) podría provocar un aumento en los precios de los alimentos y una hambruna sin precedentes en las próximas décadas.

El trigo es el tercer cereal más producido por la humanidad. Las infecciones fúngicas existentes como el Ug99 (una especie de roya del tallo ) pueden causar pérdidas de cultivos del 100% en la mayoría de las variedades modernas. Es posible recibir poco o ningún tratamiento y la infección se propaga con el viento. Si las grandes áreas productoras de cereales del mundo se infectaran, la consiguiente crisis en la disponibilidad de trigo daría lugar a picos de precios y escasez de otros productos alimenticios.

No antropogénico

De todas las especies que han vivido alguna vez, el 99% se ha extinguido. La Tierra ha experimentado numerosos eventos de extinción masiva, en los que hasta el 96% de todas las especies presentes en ese momento fueron eliminadas. Un ejemplo notable es el evento de extinción KT , que mató a los dinosaurios. Se ha argumentado que los tipos de amenazas que plantea la naturaleza son relativamente constantes, aunque esto ha sido discutido.

Impacto de asteroide

Varios asteroides han chocado con la Tierra en la historia geológica reciente. El asteroide Chicxulub , por ejemplo, tenía unas seis millas de diámetro y se teoriza que causó la extinción de dinosaurios no aviares al final del Cretácico . Actualmente no existe ningún asteroide suficientemente grande en una órbita que cruce la Tierra; sin embargo, un cometa de tamaño suficiente para causar la extinción humana podría impactar la Tierra, aunque la probabilidad anual puede ser menor de 10 −8 . El geocientífico Brian Toon estima que mientras unas pocas personas, como "algunos pescadores en Costa Rica ", podrían sobrevivir plausiblemente a un meteorito de seis millas, un meteorito de sesenta millas sería lo suficientemente grande como para "incinerar a todo el mundo". Los asteroides con un diámetro de alrededor de 1 km han impactado la Tierra en promedio una vez cada 500.000 años; probablemente sean demasiado pequeños para representar un riesgo de extinción, pero podrían matar a miles de millones de personas. Los asteroides más grandes son menos comunes. Los pequeños asteroides cercanos a la Tierra se observan regularmente y pueden impactar en cualquier lugar de la Tierra dañando a las poblaciones locales. A partir de 2013, Spaceguard estima que ha identificado el 95% de todos los NEO de más de 1 km de tamaño.

En abril de 2018, la Fundación B612 informó que "es 100% seguro que nos golpeará [un asteroide devastador], pero no estamos 100% seguros de cuándo". También en 2018, el físico Stephen Hawking , en su último libro Brief Answers to the Big Questions , consideró la colisión de un asteroide como la mayor amenaza para el planeta. En junio de 2018, el Consejo Nacional de Ciencia y Tecnología de EE. UU. Advirtió que Estados Unidos no está preparado para un evento de impacto de asteroide y ha desarrollado y publicado el "Plan de acción de la estrategia nacional de preparación de objetos cercanos a la Tierra" para prepararse mejor. Según el testimonio de expertos en el Congreso de los Estados Unidos en 2013, la NASA requeriría al menos cinco años de preparación antes de que se pudiera lanzar una misión para interceptar un asteroide.

Amenazas cósmicas

Se han identificado varias amenazas astronómicas. Los objetos masivos, por ejemplo, una estrella, un planeta grande o un agujero negro , podrían ser catastróficos si ocurriera un encuentro cercano en el Sistema Solar. En abril de 2008, se anunció que dos simulaciones de movimiento planetario a largo plazo, una en el Observatorio de París y la otra en la Universidad de California, Santa Cruz , indican un 1% de probabilidad de que la órbita de Mercurio se vuelva inestable por la acción de Júpiter. atracción gravitacional en algún momento durante la vida útil del Sol. Si esto sucediera, las simulaciones sugieren que una colisión con la Tierra podría ser uno de los cuatro resultados posibles (los otros son Mercurio chocando con el Sol, chocando con Venus o siendo expulsado del Sistema Solar por completo). Si Mercurio chocara con la Tierra, toda la vida en la Tierra podría desaparecer por completo: se cree que un asteroide de 15 km de ancho causó la extinción de los dinosaurios no aviares, mientras que Mercurio tiene 4.879 km de diámetro.

Si nuestro universo se encuentra dentro de un vacío falso , una burbuja de vacío de menor energía podría llegar a existir por casualidad o de otra manera en nuestro universo, y catalizar la conversión de nuestro universo a un estado de menor energía en un volumen que se expande casi a la velocidad de la luz. , destruyendo todo lo que sabemos sin previo aviso. Tal ocurrencia se llama decaimiento del vacío .

Otra amenaza cósmica es un estallido de rayos gamma , típicamente producido por una supernova cuando una estrella colapsa hacia adentro sobre sí misma y luego "rebota" hacia afuera en una explosión masiva. Bajo ciertas circunstancias, se cree que estos eventos producen explosiones masivas de radiación gamma que emanan hacia afuera desde el eje de rotación de la estrella. Si tal evento ocurriera orientado hacia la Tierra, las cantidades masivas de radiación gamma podrían afectar significativamente la atmósfera de la Tierra y representar una amenaza existencial para toda la vida. Tal explosión de rayos gamma pudo haber sido la causa de los eventos de extinción del Ordovícico-Silúrico . Ni este escenario ni la desestabilización de la órbita de Mercurio son probables en el futuro previsible.

Una poderosa llamarada solar o supertormenta solar, que es una disminución o aumento drástico e inusual en la producción de energía del Sol, podría tener graves consecuencias para la vida en la Tierra.

Los astrofísicos calculan actualmente que en unos pocos miles de millones de años la Tierra probablemente será tragada por la expansión del Sol en una estrella gigante roja .

Invasión extraterrestre

La vida extraterrestre inteligente , si existe, podría invadir la Tierra para exterminar y suplantar la vida humana, esclavizarla bajo un sistema colonial, robar los recursos del planeta o destruir el planeta por completo.

Aunque nunca se ha probado la evidencia de vida extraterrestre, científicos como Carl Sagan han postulado que la existencia de vida extraterrestre es muy probable. En 1969, la " Ley de Exposición Extraterrestre " se agregó al Código de Regulaciones Federales de los Estados Unidos (Título 14, Sección 1211) en respuesta a la posibilidad de contaminación biológica resultante del Programa Espacial Apolo de los Estados Unidos . Fue eliminado en 1991. Los científicos consideran que tal escenario es técnicamente posible, pero poco probable.

Un artículo en The New York Times discutió las posibles amenazas para la humanidad de enviar intencionalmente mensajes dirigidos a la vida extraterrestre al cosmos en el contexto de los esfuerzos de SETI . Varias figuras públicas como Stephen Hawking y Elon Musk han argumentado en contra de enviar tales mensajes con el argumento de que las civilizaciones extraterrestres con tecnología probablemente sean mucho más avanzadas que la humanidad y podrían representar una amenaza existencial para la humanidad.

Pandemia natural

Existen numerosos ejemplos históricos de pandemias que han tenido un efecto devastador en un gran número de personas. La escala y velocidad actuales, sin precedentes , del movimiento humano hacen que sea más difícil que nunca contener una epidemia mediante cuarentenas locales , y otras fuentes de incertidumbre y la naturaleza evolutiva del riesgo significan que las pandemias naturales pueden representar una amenaza realista para la civilización humana.

Hay varias clases de argumentos sobre la probabilidad de pandemias. Uno proviene de la historia, donde el tamaño limitado de las pandemias históricas es evidencia de que es poco probable que ocurran pandemias más grandes. Este argumento ha sido cuestionado por motivos que incluyen el riesgo cambiante debido a los patrones cambiantes de población y comportamiento entre los humanos, el registro histórico limitado y la existencia de un sesgo antrópico .

Otro argumento se basa en un modelo evolutivo que predice que los patógenos en evolución natural finalmente desarrollarán un límite superior para su virulencia. Esto se debe a que los patógenos con virulencia suficientemente alta matan rápidamente a sus huéspedes y reducen sus posibilidades de propagar la infección a nuevos huéspedes o portadores. Sin embargo, este modelo tiene límites porque la ventaja de aptitud de la virulencia limitada es principalmente una función de un número limitado de huéspedes. Cualquier patógeno con alta virulencia, alta tasa de transmisión y largo tiempo de incubación puede haber causado ya una pandemia catastrófica antes de que finalmente la virulencia se limite a través de la selección natural. Además, un patógeno que infecta a los humanos como huésped secundario e infecta principalmente a otra especie (una zoonosis ) no tiene restricciones sobre su virulencia en las personas, ya que las infecciones secundarias accidentales no afectan su evolución. Por último, en modelos donde el nivel de virulencia y la tasa de transmisión están relacionados, pueden evolucionar altos niveles de virulencia. En cambio, la virulencia está limitada por la existencia de poblaciones complejas de huéspedes con diferentes susceptibilidades a la infección, o porque algunos huéspedes están aislados geográficamente. El tamaño de la población de huéspedes y la competencia entre diferentes cepas de patógenos también pueden alterar la virulencia.

Ninguno de estos argumentos es aplicable a los patógenos modificados por bioingeniería, y esto plantea riesgos de pandemias completamente diferentes. Los expertos han concluido que "los avances en la ciencia y la tecnología podrían facilitar significativamente el desarrollo y uso de armas biológicas de alto impacto", y estos "[patógenos de bioingeniería] altamente virulentos y altamente transmisibles representan nuevas amenazas potenciales de pandemia".

Cambio climático natural

El cambio climático se refiere a un cambio duradero en el clima de la Tierra. El clima ha variado desde edades de hielo hasta períodos más cálidos en los que crecían palmeras en la Antártida. Se ha planteado la hipótesis de que también hubo un período llamado " Tierra bola de nieve " en el que todos los océanos estaban cubiertos por una capa de hielo. Estos cambios climáticos globales ocurrieron lentamente, cerca del final de la última Gran Edad de Hielo, cuando el clima se volvió más estable. Sin embargo, el cambio climático abrupto en la escala de tiempo de una década ha ocurrido a nivel regional. Una variación natural en un nuevo régimen climático (más frío o más caliente) podría representar una amenaza para la civilización.

En la historia de la Tierra, se sabe que han ocurrido muchas edades de hielo . Una edad de hielo tendría un impacto serio en la civilización porque vastas áreas de tierra (principalmente en América del Norte, Europa y Asia) podrían volverse inhabitables. Actualmente, el mundo se encuentra en un período interglacial dentro de un evento glacial mucho más antiguo. La última expansión glacial terminó hace unos 10.000 años y todas las civilizaciones evolucionaron más tarde. Los científicos no predicen que pronto ocurrirá una edad de hielo natural. La cantidad de gases que atrapan el calor emitidos a los océanos y la atmósfera de la Tierra evitará la próxima era de hielo, que de otro modo comenzaría en unos 50.000 años, y probablemente más ciclos glaciares.

Vulcanismo

Un evento geológico como una inundación masiva de basalto , vulcanismo o la erupción de un supervolcán podría conducir a un llamado invierno volcánico , similar a un invierno nuclear . Uno de esos eventos, la erupción de Toba , ocurrió en Indonesia hace unos 71.500 años. Según la teoría de la catástrofe de Toba , el evento puede haber reducido las poblaciones humanas a solo unas pocas decenas de miles de personas. Yellowstone Caldera es otro supervolcán de este tipo, que ha sufrido 142 o más erupciones formadoras de calderas en los últimos 17 millones de años. Una erupción volcánica masiva expulsaría volúmenes extraordinarios de polvo volcánico, gases tóxicos y de efecto invernadero a la atmósfera con graves efectos sobre el clima global (hacia un enfriamiento global extremo: invierno volcánico si es a corto plazo y edad de hielo si es a largo plazo) o calentamiento global ( si prevalecieran los gases de efecto invernadero).

Cuando el supervolcán de Yellowstone entró en erupción por última vez hace 640.000 años, las capas más delgadas de ceniza expulsada de la caldera se extendieron por la mayor parte de los Estados Unidos al oeste del río Mississippi y parte del noreste de México. El magma cubrió gran parte de lo que ahora es el Parque Nacional de Yellowstone y se extendió más allá, cubriendo gran parte del terreno desde el río Yellowstone en el este hasta las cataratas de Idaho en el oeste, y algunos de los flujos se extendieron hacia el norte más allá de Mammoth Springs.

Según un estudio reciente, si la caldera de Yellowstone volviera a entrar en erupción como un supervolcán, una capa de ceniza de uno a tres milímetros de espesor podría depositarse tan lejos como Nueva York, suficiente para "reducir la tracción en carreteras y pistas, cortocircuitar los transformadores eléctricos y causar problemas respiratorios". Habría centímetros de espesor en gran parte del medio oeste de los EE. UU., Lo suficiente como para interrumpir los cultivos y el ganado, especialmente si sucediera en un momento crítico de la temporada de crecimiento. La ciudad más afectada probablemente sería Billings, Montana , con una población de 109.000 habitantes, que el modelo predijo que estaría cubierta de cenizas con un espesor estimado de 1,03 a 1,8 metros.

El principal efecto a largo plazo se produce a través del cambio climático global, que reduce la temperatura a nivel mundial entre 5 y 15 grados C durante una década, junto con los efectos directos de los depósitos de ceniza en sus cultivos. Un gran supervolcán como Toba depositaría uno o dos metros de espesor de ceniza en un área de varios millones de kilómetros cuadrados (1000 kilómetros cúbicos equivalen a un metro de espesor de ceniza esparcida en un millón de kilómetros cuadrados). Si eso sucediera en alguna zona agrícola densamente poblada, como India, podría destruir una o dos temporadas de cultivos para dos mil millones de personas.

Sin embargo, Yellowstone no muestra signos de supererupción en la actualidad, y no es seguro que ocurra una supererupción futura allí.

La investigación publicada en 2011 encuentra evidencia de que las erupciones volcánicas masivas causaron una combustión masiva de carbón, lo que respalda los modelos para la generación significativa de gases de efecto invernadero. Los investigadores han sugerido que las erupciones volcánicas masivas a través de lechos de carbón en Siberia generarían importantes gases de efecto invernadero y causarían un efecto invernadero desbocado . Las erupciones masivas también pueden arrojar suficientes escombros piroclásticos y otros materiales a la atmósfera para bloquear parcialmente el sol y causar un invierno volcánico , como sucedió en menor escala en 1816 después de la erupción del Monte Tambora , el llamado Año sin verano . Tal erupción podría causar la muerte inmediata de millones de personas a varios cientos de millas de la erupción, y tal vez miles de millones de muertes en todo el mundo, debido al fracaso de los monzones , lo que resultaría en importantes pérdidas de cosechas que provocarían hambrunas a gran escala.

Un concepto mucho más especulativo es el verneshot : una hipotética erupción volcánica causada por la acumulación de gas en las profundidades de un cratón . Tal evento puede ser lo suficientemente fuerte como para lanzar una cantidad extrema de material desde la corteza y el manto hacia una trayectoria suborbital .

Mitigación propuesta

La defensa en profundidad es un marco útil para clasificar las medidas de mitigación de riesgos en tres niveles de defensa:

- Prevención : Reducir la probabilidad de que ocurra una catástrofe en primer lugar. Ejemplo: Medidas para prevenir brotes de nuevas enfermedades altamente infecciosas.

- Respuesta : Prevenir la escalada de una catástrofe a nivel mundial. Ejemplo: medidas para evitar la escalada de un intercambio nuclear a pequeña escala en una guerra nuclear total.

- Resiliencia : Incrementar la resiliencia de la humanidad (contra la extinción) frente a catástrofes globales. Ejemplo: medidas para aumentar la seguridad alimentaria durante un invierno nuclear.

La extinción humana es más probable cuando las tres defensas son débiles, es decir, "por riesgos que es poco probable que prevenimos, a los que es poco probable que respondamos con éxito y que no seamos resistentes".

La naturaleza sin precedentes de los riesgos existenciales plantea un desafío especial en el diseño de medidas de mitigación de riesgos, ya que la humanidad no podrá aprender de un historial de eventos anteriores.

La gestión planetaria y el respeto de los límites planetarios se han propuesto como enfoques para prevenir catástrofes ecológicas. Dentro del alcance de estos enfoques, el campo de la geoingeniería abarca la manipulación y la ingeniería deliberada a gran escala del entorno planetario para combatir o contrarrestar los cambios antropogénicos en la química atmosférica. La colonización espacial es una alternativa propuesta para mejorar las probabilidades de sobrevivir a un escenario de extinción. Las soluciones de este alcance pueden requerir ingeniería a megaescala . Se ha propuesto el almacenamiento de alimentos a nivel mundial, pero el costo monetario sería alto. Además, probablemente contribuiría a los millones actuales de muertes por año debido a la desnutrición .

Algunos supervivientes almacenan los retiros de supervivencia con suministros de alimentos para varios años.

La Bóveda Global de Semillas de Svalbard está enterrada a 120 m (400 pies) dentro de una montaña en una isla en el Ártico . Está diseñado para contener 2.500 millones de semillas de más de 100 países como medida de precaución para preservar los cultivos del mundo. La roca circundante está a -6 ° C (21 ° F) (a partir de 2015) pero la bóveda se mantiene a -18 ° C (0 ° F) mediante refrigeradores que funcionan con carbón de origen local.

De manera más especulativa, si la sociedad continúa funcionando y si la biosfera permanece habitable, las necesidades calóricas de la población humana actual podrían, en teoría, satisfacerse durante una ausencia prolongada de luz solar, con una planificación anticipada suficiente. Las soluciones conjeturadas incluyen cultivar hongos en la biomasa vegetal muerta que quedó como consecuencia de la catástrofe, convertir celulosa en azúcar o alimentar con gas natural a las bacterias que digieren el metano.

Riesgos catastróficos globales y gobernanza global

Una gobernanza global insuficiente crea riesgos en el ámbito social y político, pero los mecanismos de gobernanza se desarrollan más lentamente que el cambio tecnológico y social. Los gobiernos, el sector privado y el público en general están preocupados por la falta de mecanismos de gobernanza para abordar de manera eficiente los riesgos, negociar y adjudicar entre intereses diversos y en conflicto. Esto se subraya aún más al comprender la interconexión de los riesgos sistémicos globales. En ausencia o anticipación de la gobernanza global, los gobiernos nacionales pueden actuar individualmente para comprender, mitigar y prepararse mejor para las catástrofes globales.

Planes de emergencia climática

En 2018, el Club de Roma pidió una mayor acción contra el cambio climático y publicó su Plan de Emergencia Climática, que propone diez puntos de acción para limitar el aumento de la temperatura media global a 1,5 grados centígrados. Además, en 2019, el Club publicó el Plan de emergencia planetario más completo.

Organizaciones

El Boletín de los Científicos Atómicos (fundado en 1945) es una de las organizaciones de riesgo global más antiguas, fundada después de que el público se alarmó por el potencial de la guerra atómica después de la Segunda Guerra Mundial. Estudia los riesgos asociados con la guerra y la energía nucleares y es famoso por mantener el Reloj del Juicio Final establecido en 1947. El Foresight Institute ( fundado en 1986) examina los riesgos de la nanotecnología y sus beneficios. Fue una de las primeras organizaciones en estudiar las consecuencias no deseadas de una tecnología que de otro modo sería inofensiva y se volvió loca a escala global. Fue fundada por K. Eric Drexler, quien postuló " sustancia viscosa gris ".

A partir de 2000, un número creciente de científicos, filósofos y multimillonarios de la tecnología crearon organizaciones dedicadas al estudio de los riesgos globales tanto dentro como fuera de la academia.

Las organizaciones no gubernamentales (ONG) independientes incluyen el Machine Intelligence Research Institute (fundado en 2000), que tiene como objetivo reducir el riesgo de una catástrofe causada por la inteligencia artificial, con donantes como Peter Thiel y Jed McCaleb . La Iniciativa de Amenazas Nucleares (est. 2001) busca reducir las amenazas globales de amenazas nucleares, biológicas y químicas, y la contención de daños después de un evento. Mantiene un índice de seguridad del material nuclear. La Lifeboat Foundation (fundada en 2009) financia la investigación para prevenir una catástrofe tecnológica. La mayor parte del dinero de la investigación financia proyectos en universidades. El Global Catastrophic Risk Institute (creado en 2011) es un grupo de expertos para el riesgo catastrófico. Está financiado por la ONG Emprendedores Sociales y Ambientales. La Global Challenges Foundation (fundada en 2012), con sede en Estocolmo y fundada por Laszlo Szombatfalvy , publica un informe anual sobre el estado de los riesgos globales. El Future of Life Institute (fundado en 2014) tiene como objetivo apoyar la investigación y las iniciativas para salvaguardar la vida considerando las nuevas tecnologías y los desafíos que enfrenta la humanidad. Elon Musk es uno de sus mayores donantes. El Center on Long-Term Risk (est. 2016), anteriormente conocido como el Foundational Research Institute, es una organización británica centrada en reducir los riesgos de sufrimiento astronómico ( s-risk ) de las tecnologías emergentes.

Las organizaciones universitarias incluyen el Future of Humanity Institute ( fundado en 2005) que investiga las cuestiones del futuro a largo plazo de la humanidad, en particular el riesgo existencial. Fue fundada por Nick Bostrom y tiene su sede en la Universidad de Oxford. El Centro para el Estudio del Riesgo Existencial (est. 2012) es una organización con sede en la Universidad de Cambridge que estudia cuatro riesgos tecnológicos principales: inteligencia artificial, biotecnología, calentamiento global y guerra. Todos son riesgos creados por el hombre, como explicó Huw Price a la agencia de noticias AFP, "Parece una predicción razonable que en algún momento de este o el próximo siglo la inteligencia escapará de las limitaciones de la biología". Agregó que cuando esto suceda, "ya no somos las cosas más inteligentes que existen" y correremos el riesgo de quedar a merced de "máquinas que no son maliciosas, pero cuyos intereses no nos incluyen a nosotros". Stephen Hawking fue asesor en funciones. La Alianza del Milenio para la Humanidad y la Biosfera es una organización con sede en la Universidad de Stanford que se centra en muchos problemas relacionados con la catástrofe global al reunir a miembros del mundo académico en humanidades. Fue fundada por Paul Ehrlich entre otros. La Universidad de Stanford también tiene el Centro de Seguridad y Cooperación Internacional que se enfoca en la cooperación política para reducir el riesgo catastrófico global. El Centro de Seguridad y Tecnología Emergente se estableció en enero de 2019 en la Escuela de Servicio Exterior Walsh de Georgetown y se centrará en la investigación de políticas de tecnologías emergentes con un énfasis inicial en la inteligencia artificial. Recibieron una subvención de 55 millones de dólares de Good Ventures según lo sugerido por el Open Philanthropy Project .

Otros grupos de evaluación de riesgos tienen su sede o forman parte de organizaciones gubernamentales. La Organización Mundial de la Salud (OMS) incluye una división llamada Alerta y Respuesta Global (GAR) que monitorea y responde a la crisis epidémica mundial. GAR ayuda a los estados miembros con la capacitación y coordinación de la respuesta a las epidemias. La Agencia de los Estados Unidos para el Desarrollo Internacional (USAID) tiene su Programa de Amenazas Pandémicas Emergentes que tiene como objetivo prevenir y contener las pandemias generadas naturalmente en su origen. El Laboratorio Nacional Lawrence Livermore tiene una división llamada Dirección Principal de Seguridad Global que investiga en nombre del gobierno cuestiones como la bioseguridad y la lucha contra el terrorismo.

Historia

Historia temprana del pensamiento sobre la extinción humana

Antes de los siglos XVIII y XIX, se veía con escepticismo la posibilidad de que los humanos u otros organismos pudieran extinguirse. Contradecía el principio de plenitud , una doctrina de que todas las cosas posibles existen. El principio se remonta a Aristóteles y fue un principio importante de la teología cristiana. La doctrina fue socavada gradualmente por la evidencia de las ciencias naturales, en particular el descubrimiento de evidencia fósil de especies que parecían ya no existir, y el desarrollo de teorías de la evolución. En El origen de las especies , Darwin discutió la extinción de especies como un proceso natural y un componente central de la selección natural. En particular, Darwin se mostró escéptico sobre la posibilidad de extinciones repentinas, viéndolo como un proceso gradual. Sostuvo que la abrupta desaparición de especies del registro fósil no era evidencia de extinciones catastróficas, sino más bien una función de lagunas no reconocidas en el registro.

A medida que la posibilidad de extinción se estableció más ampliamente en las ciencias, también lo hizo la perspectiva de la extinción humana. Más allá de la ciencia, la extinción humana se exploró en la literatura. Los autores y poetas románticos se interesaron especialmente por el tema. Lord Byron escribió sobre la extinción de la vida en la tierra en su poema de 1816 ' Oscuridad ', y en 1824 imaginó que la humanidad se vería amenazada por el impacto de un cometa y empleó un sistema de misiles para defenderse de él. La novela de 1826 de Mary Shelley , El último hombre, se desarrolla en un mundo donde la humanidad ha sido casi destruida por una misteriosa plaga.

Era atómica

La invención de la bomba atómica provocó una ola de discusión sobre el riesgo de extinción humana entre científicos, intelectuales y el público en general. En un ensayo de 1945, Bertrand Russell escribió que "[L] a perspectiva para la raza humana es sombría más allá de todo precedente. La humanidad se enfrenta a una alternativa clara: o todos moriremos, o tendremos que adquirir algún grado leve. de sentido común ". Una encuesta de Gallup de 1950 encontró que el 19% de los estadounidenses creía que otra guerra mundial significaría "el fin de la humanidad".

El descubrimiento del " invierno nuclear " a principios de la década de 1980, un mecanismo específico por el cual la guerra nuclear podría resultar en la extinción humana, volvió a plantear la cuestión. Escribiendo sobre estos hallazgos en 1983, Carl Sagan argumentó que medir la maldad de la extinción únicamente en términos de aquellos que mueren "oculta su impacto total", y que la guerra nuclear "pone en peligro a todos nuestros descendientes, mientras haya humanos. "

Era moderna

El libro de John Leslie de 1996 El fin del mundo fue un tratamiento académico de la ciencia y la ética de la extinción humana. En él, Leslie consideró una variedad de amenazas a la humanidad y lo que tienen en común. En 2003, el astrónomo británico Royal Sir Martin Rees publicó Our Final Hour , en el que argumenta que los avances en ciertas tecnologías crean nuevas amenazas para la supervivencia de la humanidad, y que el siglo XXI puede ser un momento crítico en la historia cuando se decide el destino de la humanidad. Editado por Nick Bostrom y Milan M. Ćirković , Global Catastrophic Risks se publicó en 2008, una colección de ensayos de 26 académicos sobre varios riesgos catastróficos y existenciales globales. El libro de 2020 de Toby Ord , El precipicio: riesgo existencial y el futuro de la humanidad, sostiene que prevenir los riesgos existenciales es una de las cuestiones morales más importantes de nuestro tiempo. El libro analiza, cuantifica y compara diferentes riesgos existenciales, concluyendo que los mayores riesgos los presentan la inteligencia artificial no alineada y la biotecnología.

Ver también

- Ficción apocalíptica y postapocalíptica

- Carrera armamentista de inteligencia artificial

- Hipótesis cataclísmica del cambio de polos

- Resiliencia comunitaria

- Degeneración social

- Escatología

- Riesgo extremo

- Estado fallido

- Paradoja de fermi

- Prospectiva (psicología)

- Futuro de la Tierra

- Futuro del sistema solar

- Problema global

- Informe de riesgos globales

- Gran filtro

- Extinción del holoceno

- Evento de impacto

- Lista de problemas globales

- Proliferación nuclear

- Problema de contexto externo

- Límites planetarios

- Eventos raros

- La sexta extinción: una historia antinatural (libro de no ficción)

- Colapso social

- Evolución especulativa : estudio de animales hipotéticos que algún día podrían habitar la Tierra después de una catástrofe existencial.

- Supervivencia

- Riesgo de cola

- Cronología del futuro lejano

- Destino final del universo

- Advertencia de los científicos mundiales a la humanidad

Notas

Otras lecturas

- Toby Ord (2020). El precipicio: riesgo existencial y el futuro de la humanidad . Publicación de Bloomsbury. ISBN 9781526600219

- Holt, Jim , "El poder del pensamiento catastrófico" (revisión de Toby Ord , El precipicio: riesgo existencial y el futuro de la humanidad , Hachette, 2020, 468 págs.), The New York Review of Books , vol. LXVIII, no. 3 (25 de febrero de 2021), págs. 26-29. Jim Holt escribe (p. 28): "Ya sea que esté buscando una cura para el cáncer, o persiga una carrera académica o artística, o se dedique a establecer instituciones más justas, una amenaza para el futuro de la humanidad también es una amenaza para la importancia de lo que haces ".

- Avin, Shahar; Wintle, Bonnie C .; Weitzdörfer, Julius; ó Héigeartaigh, Seán S .; Sutherland, William J .; Rees, Martin J. (2018). "Clasificación de riesgos catastróficos globales" . Futuros . 102 : 20-26. doi : 10.1016 / j.futures.2018.02.001 .

- Corey S. Powell (2000). "Veinte formas en que el mundo podría acabar de repente" , Revista Discover

- Martin Rees (2004). Nuestra última hora: la advertencia de un científico: cómo el terror, el error y los desastres ambientales amenazan el futuro de la humanidad en este siglo, en la Tierra y más allá . ISBN 0-465-06863-4

- Jean-Francois Rischard (2003). High Noon 20 problemas globales, 20 años para resolverlos . ISBN 0-465-07010-8

- Edward O. Wilson (2003). El futuro de la vida . ISBN 0-679-76811-4

- Roger-Maurice Bonnet y Lodewijk Woltjer , sobreviviendo 1000 siglos ¿Podemos hacerlo? (2008), Springer-Praxis Books.

- Derrick Jensen (2006) Fin del juego ( ISBN 1-58322-730-X ).

- Jared Diamond , Collapse: How Societies Choose to Fail or Succeed , Penguin Books , 2005 y 2011 ( ISBN 9780241958681 ).

- Huesemann, Michael H. y Joyce A. Huesemann (2011). Technofix: Por qué la tecnología no nos salvará ni al medio ambiente , Capítulo 6, "Sostenibilidad o colapso", New Society Publishers , Isla Gabriola, Columbia Británica, Canadá, 464 páginas ( ISBN 0865717044 ).

- Joel Garreau , Evolución radical , 2005 ( ISBN 978-0385509657 ).

- John A. Leslie (1996). El fin del mundo ( ISBN 0-415-14043-9 ).

- Donella Meadows (1972). Los límites del crecimiento ( ISBN 0-87663-165-0 ).

- Joseph Tainter , (1990). El colapso de sociedades complejas , Cambridge University Press , Cambridge, Reino Unido ( ISBN 9780521386739 ).

enlaces externos

- Informes anuales sobre riesgo global de la Fundación Global Challenges

- Centrarse en el riesgo a largo plazo

- "Qué camino a seguir" de The Guardian . Diez científicos nombran los mayores peligros para la Tierra y evalúan las posibilidades de que ocurran. 14 de abril de 2005.

- Stephen Petranek: 10 formas en que el mundo podría terminar , una charla TED

- "Las 10 mejores formas de destruir la Tierra" . livescience.com . LiveScience . Archivado desde el original el 1 de enero de 2011.

- "¿Estamos en el camino hacia el colapso de la civilización?" . BBC . 19 de febrero de 2019.

- Política global de riesgo catastrófico

- La humanidad amenazada por la tormenta perfecta de crisis - estudio . The Guardian . 6 de febrero de 2020.