Interferencia catastrófica - Catastrophic interference

La interferencia catastrófica , también conocida como olvido catastrófico , es la tendencia de una red neuronal artificial a olvidar completa y abruptamente la información previamente aprendida al aprender nueva información. Las redes neuronales son una parte importante del enfoque de red y el enfoque conexionista de la ciencia cognitiva . Con estas redes, las capacidades humanas como la memoria y el aprendizaje se pueden modelar mediante simulaciones por computadora. La interferencia catastrófica es un tema importante a considerar al crear modelos conexionistas de memoria. Originalmente, la comunidad científica lo llamó la atención mediante la investigación de McCloskey y Cohen (1989) y Ratcliff (1990). Es una manifestación radical del dilema 'sensibilidad-estabilidad' o del dilema 'estabilidad-plasticidad'. Específicamente, estos problemas se refieren al desafío de crear una red neuronal artificial que sea sensible a la nueva información, pero que no se vea alterada por ella. Las tablas de búsqueda y las redes conexionistas se encuentran en los lados opuestos del espectro de plasticidad de estabilidad. El primero permanece completamente estable en presencia de nueva información, pero carece de la capacidad de generalizar , es decir, inferir principios generales, a partir de nuevos insumos. Por otro lado, las redes conexionistas como la red de retropropagación estándar pueden generalizarse a entradas invisibles, pero son muy sensibles a la nueva información. Los modelos de retropropagación pueden considerarse buenos modelos de la memoria humana en la medida en que reflejan la capacidad humana de generalizar, pero estas redes a menudo exhiben menos estabilidad que la memoria humana. En particular, estas redes de retropropagación son susceptibles a interferencias catastróficas. Este es un problema al modelar la memoria humana, porque a diferencia de estas redes, los humanos generalmente no muestran un olvido catastrófico.

Historia de interferencia catastrófica

El término interferencia catastrófica fue acuñado originalmente por McCloskey y Cohen (1989), pero también fue llamado la atención de la comunidad científica por la investigación de Ratcliff (1990).

El problema del aprendizaje secuencial : McCloskey y Cohen (1989)

McCloskey y Cohen (1989) señalaron el problema de la interferencia catastrófica durante dos experimentos diferentes con el modelado de redes neuronales de retropropagación.

- Experimento 1: Aprender las operaciones de suma de unos y de dos

En su primer experimento, entrenaron una red neuronal de retropropagación estándar en un solo conjunto de entrenamiento que constaba de 17 problemas de unidades de un solo dígito (es decir, 1 + 1 a 9 + 1, y 1 + 2 a 1 + 9) hasta que la red pudiera representar y responder adecuadamente a todos ellos. El error entre el resultado real y el resultado deseado disminuyó constantemente a lo largo de las sesiones de capacitación, lo que reflejó que la red aprendió a representar mejor los resultados deseados en las pruebas. A continuación, entrenaron a la red en un solo conjunto de entrenamiento que constaba de 17 problemas de dos dígitos de un solo dígito (es decir, 2 + 1 a 2 + 9 y 1 + 2 a 9 + 2) hasta que la red pudiera representar, responder adecuadamente a todos los ellos. Notaron que su procedimiento era similar a cómo un niño aprendería sus operaciones de suma. Después de cada prueba de aprendizaje sobre los hechos de dos, se evaluó el conocimiento de la red sobre los hechos de suma de dos y de uno. Al igual que los hechos de uno, los dos hechos fueron fácilmente aprendidos por la red. Sin embargo, McCloskey y Cohen notaron que la red ya no podía responder adecuadamente a los problemas de suma de unos, incluso después de una prueba de aprendizaje de los problemas de suma de dos. El patrón de salida producido en respuesta a los hechos de unos a menudo se asemejaba más a un patrón de salida para un número incorrecto que el patrón de salida para un número correcto. Esto se considera una cantidad drástica de error. Además, los problemas 2 + 1 y 2 + 1, que se incluyeron en ambos conjuntos de entrenamiento, incluso mostraron una interrupción dramática durante las primeras pruebas de aprendizaje de los dos hechos.

- Experimento 2: Replicación del estudio de Barnes y Underwood (1959) En su segundo modelo conexionista, McCloskey y Cohen intentaron replicar el estudio sobre interferencia retroactiva en humanos de Barnes y Underwood (1959). Entrenaron el modelo en listas AB y AC y usaron un patrón de contexto en el vector de entrada (patrón de entrada) para diferenciar entre las listas. Específicamente, la red fue entrenada para responder con la respuesta B correcta cuando se muestra el estímulo A y el patrón de contexto AB y para responder con la respuesta C correcta cuando se muestra el estímulo A y el patrón de contexto AC. Cuando el modelo se entrenó simultáneamente en los elementos AB y AC, la red aprendió rápidamente todas las asociaciones correctamente. En el entrenamiento secuencial se entrenó primero la lista AB, seguida de la lista AC. Después de cada presentación de la lista AC, se midió el rendimiento de las listas AB y AC. Descubrieron que la cantidad de entrenamiento en la lista AC en el estudio de Barnes and Underwood que conduce a un 50% de respuestas correctas, conduce a casi un 0% de respuestas correctas por parte de la red de retropropagación. Además, encontraron que la red tendía a mostrar respuestas que se parecían al patrón de respuesta C cuando se le solicitaba a la red que diera el patrón de respuesta B. Esto indicó que la lista AC aparentemente había sobrescrito la lista AB. Esto podría compararse con aprender la palabra perro, seguido de aprender la palabra taburete y luego descubrir que no puede reconocer bien la palabra gato, sino pensar en la palabra taburete cuando se le presenta la palabra perro.

McCloskey y Cohen intentaron reducir la interferencia a través de una serie de manipulaciones que incluyen cambiar el número de unidades ocultas, cambiar el valor del parámetro de tasa de aprendizaje, sobreentrenamiento en la lista AB, congelar ciertos pesos de conexión, cambiar los valores objetivo 0 y 1 en lugar de 0,1 y 0,9 . Sin embargo, ninguna de estas manipulaciones redujo satisfactoriamente la catastrófica interferencia exhibida por las redes.

En general, McCloskey y Cohen (1989) concluyeron que:

- al menos alguna interferencia ocurrirá siempre que el nuevo aprendizaje altere los pesos involucrados que representan

- Cuanto mayor sea la cantidad de aprendizaje nuevo, mayor será la interrupción del conocimiento antiguo

- La interferencia fue catastrófica en las redes de retropropagación cuando el aprendizaje fue secuencial pero no concurrente.

Restricciones impuestas por las funciones de aprendizaje y olvido : Ratcliff (1990)

Ratcliff (1990) utilizó múltiples conjuntos de modelos de retropropagación aplicados a procedimientos de memoria de reconocimiento estándar, en los que los elementos se aprendían secuencialmente. Después de inspeccionar los modelos de rendimiento de reconocimiento, encontró dos problemas importantes:

- La información bien aprendida se olvidó catastróficamente a medida que se aprendía nueva información en redes de retropropagación tanto pequeñas como grandes.

Incluso una prueba de aprendizaje con nueva información resultó en una pérdida significativa de la información anterior, en paralelo con los hallazgos de McCloskey y Cohen (1989). Ratcliff también descubrió que las salidas resultantes eran a menudo una combinación de la entrada anterior y la nueva entrada. En redes más grandes, los elementos aprendidos en grupos (p. Ej., AB y luego CD) eran más resistentes al olvido que los elementos aprendidos individualmente (p. Ej., A, luego B, luego C ...). Sin embargo, el olvido de los elementos aprendidos en grupos aún era grande. Agregar nuevas unidades ocultas a la red no redujo la interferencia.

- La discriminación entre los elementos estudiados y los elementos no vistos anteriormente disminuyó a medida que la red aprendía más.

Este hallazgo contradice los estudios sobre la memoria humana, que indicaron que la discriminación aumenta con el aprendizaje. Ratcliff intentó aliviar este problema agregando 'nodos de respuesta' que responderían selectivamente a entradas nuevas y antiguas. Sin embargo, este método no funcionó ya que estos nodos de respuesta se activarían para todas las entradas. Un modelo que utilizó un patrón de contexto tampoco logró aumentar la discriminación entre elementos nuevos y antiguos.

Soluciones propuestas

La principal causa de la interferencia catastrófica parece ser la superposición de las representaciones en la capa oculta de las redes neuronales distribuidas. En una representación distribuida, cada entrada tiende a crear cambios en los pesos de muchos de los nodos. El olvido catastrófico ocurre porque cuando se cambian muchos de los pesos en los que "se almacena el conocimiento", es poco probable que el conocimiento previo se mantenga intacto. Durante el aprendizaje secuencial, las entradas se mezclan y las nuevas entradas se superponen a las antiguas. Otra forma de conceptualizar esto es visualizando el aprendizaje como un movimiento a través de un espacio de peso. Este espacio de ponderaciones se puede comparar con una representación espacial de todas las posibles combinaciones de ponderaciones que podría poseer la red. Cuando una red aprende por primera vez a representar un conjunto de patrones, encuentra un punto en el espacio de peso que le permite reconocer todos esos patrones. Sin embargo, cuando la red aprenda un nuevo conjunto de patrones, se moverá a un lugar en el espacio de peso para el que la única preocupación es el reconocimiento de los nuevos patrones. Para reconocer ambos conjuntos de patrones, la red debe encontrar un lugar en el espacio de peso adecuado para reconocer tanto los patrones nuevos como los antiguos.

A continuación se muestran una serie de técnicas que tienen apoyo empírico para reducir con éxito la interferencia catastrófica en las redes neuronales de retropropagación:

Ortogonalidad

Muchas de las primeras técnicas para reducir la superposición de representaciones implicaban hacer que los vectores de entrada o los patrones de activación de unidades ocultas fueran ortogonales entre sí. Lewandowsky y Li (1995) observaron que la interferencia entre patrones aprendidos secuencialmente se minimiza si los vectores de entrada son ortogonales entre sí. Se dice que los vectores de entrada son ortogonales entre sí si el producto por pares de sus elementos a través de los dos vectores suma cero. Por ejemplo, se dice que los patrones [0,0,1,0] y [0,1,0,0] son ortogonales porque (0 × 0 + 0 × 1 + 1 × 0 + 0 × 0) = 0. Una de las técnicas que pueden crear representaciones ortogonales en las capas ocultas implica la codificación de características bipolares (es decir, la codificación utilizando -1 y 1 en lugar de 0 y 1). Los patrones ortogonales tienden a producir menos interferencias entre sí. Sin embargo, no todos los problemas de aprendizaje se pueden representar utilizando este tipo de vectores y algunos estudios informan que el grado de interferencia sigue siendo problemático con los vectores ortogonales.

Técnica de afilado de nodos

Según French (1991), la interferencia catastrófica surge en feedforward redes de retropropagación debido a la interacción de activaciones de nodo, o superposición de activación, que se produce en las representaciones distribuidas en la capa oculta. Las redes neuronales que emplean representaciones muy localizadas no muestran una interferencia catastrófica debido a la falta de superposición en la capa oculta. Por lo tanto, French sugirió que reducir el valor de la superposición de activación en la capa oculta reduciría la interferencia catastrófica en las redes distribuidas. Específicamente, propuso que esto podría hacerse cambiando las representaciones distribuidas en la capa oculta a representaciones "semidistribuidas". Una representación 'semidistribuida' tiene menos nodos ocultos que están activos, y / o un valor de activación más bajo para estos nodos, para cada representación, lo que hará que las representaciones de las diferentes entradas se superpongan menos en la capa oculta. French recomendó que esto se pudiera hacer a través del 'afilado de activación', una técnica que aumenta ligeramente la activación de un cierto número de los nodos más activos en la capa oculta, reduce ligeramente la activación de todas las demás unidades y luego cambia la entrada a - ponderaciones de capa oculta para reflejar estos cambios de activación (similar a la propagación inversa de errores).

Regla de novedad

Kortge (1990) propuso una regla de aprendizaje para entrenar redes neuronales, llamada "regla de la novedad", para ayudar a aliviar la interferencia catastrófica. Como sugiere su nombre, esta regla ayuda a la red neuronal a aprender solo los componentes de una nueva entrada que difieren de una entrada anterior. En consecuencia, la regla de la novedad cambia solo los pesos que no se dedicaron previamente a almacenar información, reduciendo así la superposición en las representaciones en las unidades ocultas. Para aplicar la regla de novedad, durante el aprendizaje, el patrón de entrada se reemplaza por un vector de novedad que representa los componentes que difieren. Cuando la regla de la novedad se usa en una red de retropropagación estándar, no se olvidan, o disminuyen, los elementos antiguos cuando los elementos nuevos se presentan secuencialmente. Sin embargo, una limitación es que esta regla solo se puede usar con redes autocodificadoras o autoasociativas, en las que la respuesta de destino para la capa de salida es idéntica al patrón de entrada.

Redes de preentrenamiento

McRae y Hetherington (1993) argumentaron que los humanos, a diferencia de la mayoría de las redes neuronales, no asumen nuevas tareas de aprendizaje con un conjunto aleatorio de pesos. Más bien, las personas tienden a aportar una gran cantidad de conocimientos previos a una tarea y esto ayuda a evitar el problema de la interferencia. Demostraron que cuando una red se entrena previamente con una muestra aleatoria de datos antes de comenzar una tarea de aprendizaje secuencial, este conocimiento previo naturalmente limitará cómo se puede incorporar la nueva información. Esto ocurriría porque una muestra aleatoria de datos de un dominio que tiene un alto grado de estructura interna, como el idioma inglés, la capacitación capturaría las regularidades o patrones recurrentes que se encuentran dentro de ese dominio. Dado que el dominio se basa en regularidades, un elemento recién aprendido tenderá a ser similar a la información aprendida previamente, lo que permitirá que la red incorpore nuevos datos con poca interferencia con los datos existentes. Específicamente, un vector de entrada que sigue el mismo patrón de regularidades que los datos previamente entrenados no debería causar un patrón de activación drásticamente diferente en la capa oculta o alterar drásticamente los pesos.

Ensayo

Robins (1995) describió que el olvido catastrófico se puede prevenir mediante mecanismos de ensayo. Esto significa que cuando se agrega nueva información, la red neuronal se vuelve a entrenar en parte de la información aprendida previamente. En general, sin embargo, la información aprendida previamente puede no estar disponible para tal reentrenamiento. Una solución para esto es el "pseudo-ensayo", en el que la red no se vuelve a entrenar en los datos anteriores reales sino en representaciones de ellos. Varios métodos se basan en este mecanismo general.

Redes pseudo-recurrentes

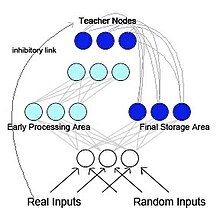

French (1997) propuso una red de retropropagación pseudo-recurrente (ver Figura 2). En este modelo, la red se divide en dos subredes funcionalmente distintas pero que interactúan. Este modelo está inspirado biológicamente y se basa en la investigación de McClelland et al. (1995) McClelland y sus colegas sugirieron que el hipocampo y el neocórtex actúan como sistemas de memoria separables pero complementarios, con el hipocampo para el almacenamiento de la memoria a corto plazo y el neocórtex para el almacenamiento de la memoria a largo plazo . La información almacenada inicialmente en el hipocampo se puede "transferir" al neocórtex mediante reactivación o reproducción. En la red pseudo-recurrente, una de las subredes actúa como un área de procesamiento temprano, similar al hipocampo, y funciona para aprender nuevos patrones de entrada. La otra subred actúa como un área de almacenamiento final, similar a la neocorteza. Sin embargo, a diferencia de McClelland et al. (1995), el área de almacenamiento final envía la representación generada internamente al área de procesamiento inicial. Esto crea una red recurrente. French propuso que este entrelazado de viejas representaciones con nuevas representaciones es la única forma de reducir el olvido radical. Dado que lo más probable es que el cerebro no tenga acceso a los patrones de entrada originales, los patrones que se retroalimentarían al neocórtex serían representaciones generadas internamente llamadas pseudopatrones . Estos pseudopatrones son aproximaciones de entradas anteriores y se pueden intercalar con el aprendizaje de nuevas entradas.

Memoria auto-refrescante

Inspirándose e independientemente de Ans y Rousset (1997) también propusieron una arquitectura neuronal artificial de dos redes con auto-actualización de la memoria que supera la interferencia catastrófica cuando las tareas de aprendizaje secuencial se llevan a cabo en redes distribuidas entrenadas por retropropagación. El principio es aprender nuevos patrones externos simultáneamente con pseudopatrones generados internamente, o 'pseudo-memorias', que reflejan la información previamente aprendida. Lo que distingue principalmente a este modelo de los que utilizan el pseudoensayo clásico en redes multicapa feedforward es un proceso reverberante que se utiliza para generar pseudopatrones. Después de una serie de reinyecciones de actividad a partir de una única semilla aleatoria, este proceso tiende a ascender a atractores de red no lineales que son más adecuados para capturar de manera óptima la estructura profunda del conocimiento distribuido dentro de los pesos de conexión que el único pase de actividad de feedforward utilizado en pseudo -ensayo. El procedimiento de autorrefrigeración de la memoria resultó ser muy eficiente en los procesos de transferencia y en el aprendizaje en serie de secuencias temporales de patrones sin un olvido catastrófico.

Reproducción generativa

En los últimos años, el pseudo-ensayo ha vuelto a ganar popularidad gracias al progreso en las capacidades de los modelos generativos profundos . Cuando se utilizan tales modelos generativos profundos para generar los "pseudodatos" que se van a ensayar, este método se denomina típicamente reproducción generativa. Esta reproducción generativa puede prevenir eficazmente el olvido catastrófico, especialmente cuando la reproducción se realiza en las capas ocultas en lugar de en el nivel de entrada.

Aprendizaje latente

El aprendizaje latente es una técnica utilizada por Gutstein y Stump (2015) para mitigar la interferencia catastrófica aprovechando el aprendizaje por transferencia . Este enfoque intenta encontrar codificaciones óptimas para cualquier clase nueva que se aprenda, de modo que sea menos probable que interfieran catastróficamente con las respuestas existentes. Dada una red que ha aprendido a discriminar entre un conjunto de clases utilizando Códigos de salida de corrección de errores (ECOC) (a diferencia de 1 código activo ), las codificaciones óptimas para las nuevas clases se eligen observando las respuestas promedio de la red a ellas. Dado que estas respuestas promedio surgieron mientras se aprendía el conjunto original de clases sin ninguna exposición a las nuevas clases , se las conoce como "Codificaciones aprendidas latentemente". Esta terminología toma prestado del concepto de aprendizaje latente , introducido por Tolman en 1930. En efecto, esta técnica utiliza el aprendizaje por transferencia para evitar interferencias catastróficas, al hacer que las respuestas de una red a las nuevas clases sean lo más coherentes posible con las respuestas existentes a las clases ya aprendidas.

Consolidación de peso elástica

Kirkpatrick y col. (2017) propuso la consolidación de peso elástico (EWC), un método para entrenar secuencialmente una sola red neuronal artificial en múltiples tareas. Esta técnica supone que algunos pesos de la red neuronal entrenada son más importantes para tareas aprendidas previamente que otros. Durante el entrenamiento de la red neuronal en una nueva tarea, los cambios en los pesos de la red se hacen menos probables cuanto mayor es su importancia. Para estimar la importancia de las ponderaciones de la red, EWC utiliza mecanismos probabilísticos, en particular la matriz de información de Fisher, pero esto también se puede hacer de otras formas.